英语原文共 6 页,剩余内容已隐藏,支付完成后下载完整资料

宽视场3D-LIDAR的自动导航下动态环境识别

K.Onda T. Oishi Y. Kuroda

lowast;Graduate School of Science of Technology, Meiji University, Tokyo, Japan (e-mail: ce182020@meiji.ac.jp) lowast;lowast;School of Science of Technology, Meiji University, Tokyo, Japan

摘要:现有的三维激光探测与测距(3D-LIDAR)技术在垂直方向上具有广阔的视野,该技术适合应用于城市区域和人群中的自主驾驶。在本文中,我们提出了一种不需要形状信息就能从物体运动中识别动态障碍物的方法。我们根据点与点之间的距离关系来判断出障碍物,并根据障碍物的中心来观察障碍物的运动。为了在动态环境中创建精确的映射,我们从点云中删除动态对象。激光雷达的大视场使得定位具有鲁棒性,明治大学Ikuta校区的实验证明了这种三维激光雷达的有用性和这种方法的有效性。

关键词:识别,障碍物检测,自动移动机器人,鲁棒估计,导航系统

- 介绍

为了使机器人能够自主驾驶和在人类生活区工作,我们需要准确的地图构建、鲁棒的定位以及考虑人的运动并进行规划控制。

传统的3D-LiDARs在水平方向上有一个大视角,通过该视角LIDARs能够识别到物体的高度信息。因此,它已被用于识别动态对象,Neuhaus等人(2009),Dewan等人(2016),Miyasaka等人(2009),Azim等人(2012),Kalyan等人(2010),Himmelsbach等人(2009),Choi等人(2013)进行过相关研究。然而,由于大多数传统研究中使用的3D- LiDARs是针对汽车的,所以在水平方向上LiDARs的视角较宽,而在垂直方向上LiDARs的视角较窄。因此,很难捕捉到附近物体的存在。换句话说,由于它无法识别附近障碍物的形状,所以不适用于在城市区域和人群中自动驾驶。因此,我们开发了在垂直方向上具有广阔视野的三维激光雷达。虽然该三维激光雷达的视场较宽,但获取的点密度变得粗糙,所以很难获得详细的形状信息。因此,我们提出了一种没有形状信息的动态障碍物运动识别方法。

图1 宽视角3D-LIDAR

表1 3D-LIADAR的规格

2、宽视角三维雷达

2.1 宽视角三维雷达的建设

我们在图1和表1中展示了开发的3D激光雷达的外观和规格。为了使机器人在城市地区工作,当它安装在地面上高1.5米处时,传感器需要能够看到距离它1米远处大小为2米的物体的全貌。普遍而言,大部分成年人身高小于2米并且步行速度接近1m/s。因此我们假定机器人可以识别并避让至少1米远处小于2米高的人。

不久之前,Sheehan等人(2014)开发了3D激光雷达。他们在一个水平转盘上垂直安装了三个LRFs。激光雷达是为全视场感知整个天空而设计的,然而,对于具有实时环境识别、定位和路径规划的自动驾驶来说,它并不是必需的。这些激光雷达之间的重要区别是,我们的激光雷达有三个LRFs,每个LRFs都安装在一个偏移角度上,以便将光束可以投射到60度以下到37.8 度以上。该特性可以使雷达有效地测量机器人周围环境,以实现自动驾驶。

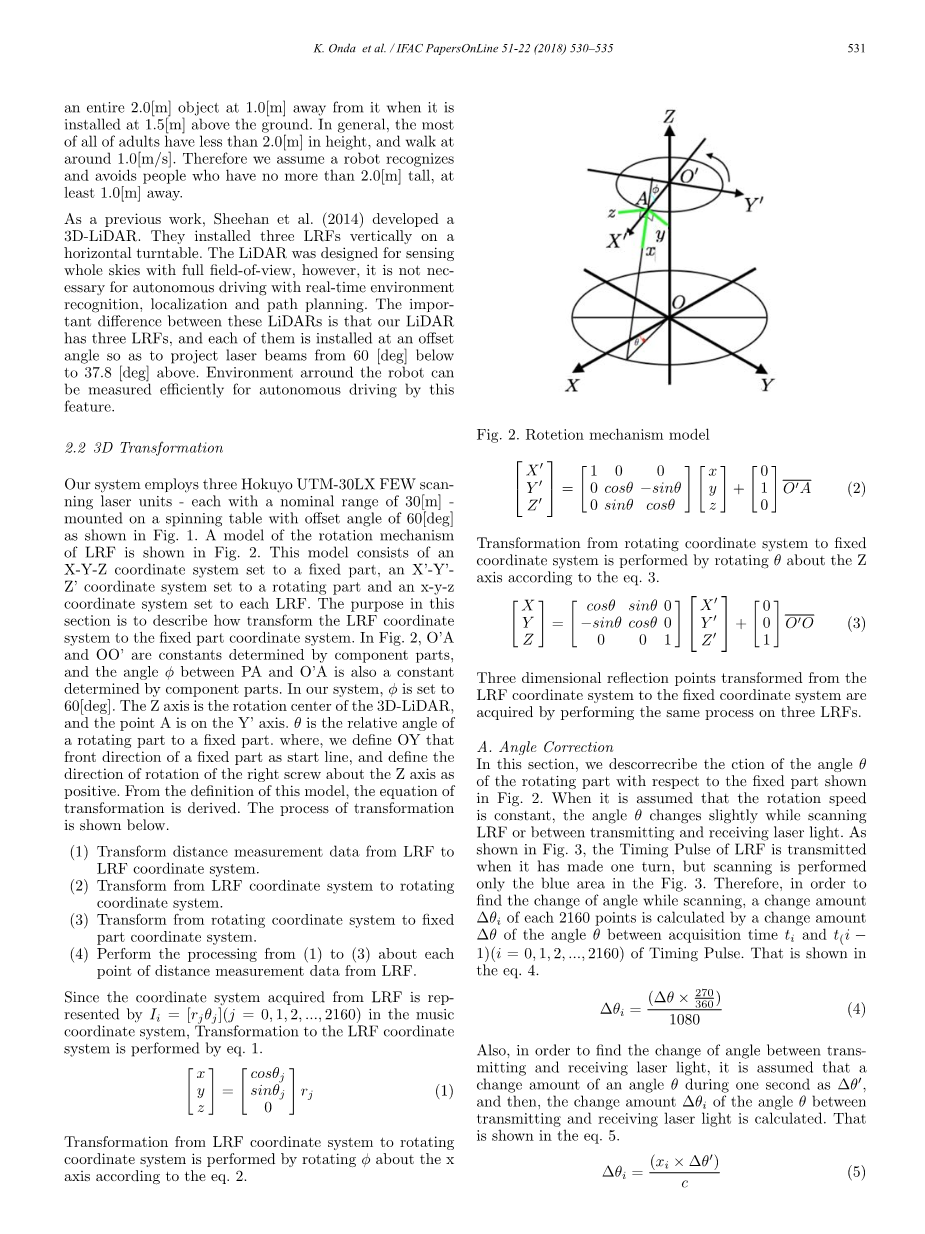

2.2 3D转换

如图1所示,我们的系统使用了三个Hokuyo UTM-30LX FEW扫描激光单元(每一个标准范围为30米)并将它们安装在一个偏置角为60度的旋转工作台上。LRF旋转机构模型如图2所示。该模型由X-Y-Z坐标系设置为固定部分,由设置为旋转部分的Xrsquo;-Yrsquo;-Zrsquo;坐标系和设置到每个LRF的X-Y-Z坐标系组成。本节的目的是描述如何将LRF坐标系转换为固定部件坐标系。在图2中,OArsquo;和OOrsquo;是由组成部分决定的常数。PA与Orsquo;A之间的角也是由组成部分决定的常数。在我们的系统中,phi;设置为60度。Z轴是3D-LiDAR的旋转中心且A点在Yrsquo;轴上。theta;是旋转部件与固定部件的相对角度。我们定义了一个固定部分的前方向作为起始线,并定义了右螺钉的旋转方向。从该模型的定义出发,我们可以导出该模型的变换方程。转换过程如下所示:

(1)将LRF距离测量数据转换为探测器坐标系统。

(2) LRF坐标系转换为旋转坐标系坐标系统。

(3)旋转坐标系到固定坐标系的变换坐标系统的一部分。

(4)分别通过(1)~(3)处理距离LRF的测量点的数据。由于从探测器获得的坐标系统是由

Ir=(rjtheta;j)(j = 0,1,2,hellip;2016)在音乐坐标系中,由式1将其变换到LRF坐标系系统。

通过该方程可在x轴上旋转phi;来实现从LRF坐标系到旋转坐标系的转换。

图2.旋转机构模型

从旋转坐标系到固定坐标系的转换是通过方程(3)对Z轴旋转theta;来实现的。

通过对三个LRF进行相同的处理,我们可得到从LRF坐标系到固定坐标系的三维反射点。

- 角度校正

在本节中,我们对旋转部分相对于图2所示的固定部分的角度theta;进行了修正。假设转速为常数时,在扫描LRF时theta;角会随着发射和接收激光轻微地变化。如图3所示,LRF的定时脉冲是在它旋转一圈时发送的,但只扫描图3中的蓝色区域。因此,为了找出扫描时角度的变化,每2160点的变化量∆theta;i是由捕获时间ti到t(iminus;1)(i=1)之间的角度theta;的变化量∆theta;由计时脉冲所得。 公式如下。

此外,为了求出发射和接收激光之间的角度变化,可假设一个角度theta;在1秒内的变化量为∆theta;,然后假定变化量为∆theta;I。 计算了激光发射与接收角的theta;。如等式5所示。

图3.LRF光束结构

其中Xi是激光获得的距离,c是光速。在执行所述的三维转换之前,这些处理是作为上面的角度theta;的偏移执行的。

B.更正的标题

在这一部分中,我们描述了当传感器安装在机器人上时滚动角度和俯仰角的校正。校正是根据所装备的IMU的信息进行的。在图4中, 将安装的传感器的机器人的固定部分设置为X-Y-Z坐标系,将系LiDAR设置为Xrsquo;-Yrsquo;-Zrsquo;坐标。本节的目的是将Xrsquo;-Yrsquo;-Zrsquo;转换为 X-Y-Z坐标系。姿态校正由等式6进行。

图4.姿态角

- 动态环境识别

在这一部分中,我们描述动态环境识别的方法。为了使机器人能够实现稳定的自主驾驶,对动态对象进行识别是非常重要的。动态对象识别是通过观察从LiDAR获得的点群的变化来实现的。

图5.获得原始点云

3.1动态对象检测

- 障碍探测

我们使用Min-Max方法(Thrun等人(2006))并将阈值识别定义为0.5米。不必要的范围是通过排除了被Min-Max方法识别为障碍点以外的点来确定并消除的。从LiDAR获取的点云信息的示例图像如图5所示。

- 欧几里德聚类

由于检测到的障碍物是作为一组点提取出来的,所以为了观察每个障碍的时间变化,本文对进行了Rusu(2010)聚类。在该方法中,使用kd-tre进行搜索并在三维空间中进行了基于欧氏距离的聚类。集群由方程7定义。Dth是两个簇间距离的一个阈值。当簇pi与簇Pj之间的最小距离小于阈值时,这两个簇被视为同一簇。其中piisin;P和pjisin;P且阈值DTH设置为 0.2米。

聚类结果如图6所示。图6中的彩色编码点云是通过这种方法生成的簇。各点云的颜色表示簇的索引。换句话说,同一簇中的云以相同的颜色着色。

图6.按聚类索引着色的聚类示例

- 跟踪

为了观察作为障碍物的簇的运动,所以需要对簇进行跟踪。在该方法中,使用扩展卡尔曼滤波器(EKF)进行跟踪。利用运动模型对前一节中获得的目标候选物体的运动进行了预测,同时利用ekf观测群相关的候选对象的变化。可根据获得的更新结果跟踪障碍物。

为了跟踪集群,将步骤k的目标候选对象x的状态量设置为x(k_k),协方差设置为p(k_k)。使用运动模型预测下一步k 1的位置。预测状态量和协方差分别表示为x(k 1_k)和p(k 1_k)。假设速度与前一个状态没有变化,并且预测的状态向量由等式8表示。

式中,f是运动模型,psi;(k_k)是k-2和k-1状态量之间的角差。预测协方差由等式9表示。

其中,F是f的雅可比矩阵,Q是系统噪声。它们分别由等式10和等式11表示。

Q的对角线分量表示动态障碍物的加速能力。

当生成目标候选的观察簇时,往往会出现多个聚类。因此,应使用欧式距离将观测聚类和预测聚类联系起来。此外,在某些情况下,预测集群不与任何观测集群相关联且观测集群与任何预测集群不相关联。在前一种情况下,我可以想象,目标物体移出了可检测的范围,或者由于遮挡而无法观察到目标物体,因此下一次预测得到预测运动的补充,以便在从遮挡中恢复时立即与目标对象相关联。如果不可观测的事件数达到一定的阈值,预测聚类就被丢弃。在后一种情况下,因为没有与任何集群相关联的集群是reg,作为新检测到的簇,它们将被添加到跟踪目标列表中。EKF跟踪目标候选人并根据其状态数量识别目标候选人。观测聚类与预测通过使用欧氏距离将聚类关联起来,然后根据相应的聚类更新候选对象。当观察星系团ZI和预测的簇xj(k1k)是一个 通过下面的方程,它被更新到XJ(k_1_(K_1)。

其中K是卡尔曼增益,I是4times;4的单位矩阵。卡尔曼增益K用方程14表示。

通过重复上述过程来跟踪障碍。根据所得到的跟踪结果所预测的障碍物速度来判断其是动态的还是静态的。即使集群被识别为动态障碍是静止的一次,它也被判断为动态障碍。

3.2障碍地图建设

我们使用二维映射作为路径规划的配置空间。在驱动过程中,可根据从LiDAR获取的点云信息创建配置空间。我们研制的LIDAR具有很宽的视角,甚至可以探测到机器人附近低高度的障碍物。

通过实时点云可以探测到可能发生碰撞的障碍物。此时,仅使用距所获得点云最低点0.3米或以上和距激光雷达上侧1.4米或以下的点云。然后,将检测到的点云转换为二维网格图,构造障碍物图。

3.3三维地图构建

在这一部分中,我们描述了一个三维地图的局部化构造。在地图构建中,采用了从LiDAR中获取的三维点云,并给出了相应的实现方法。在该方法中,需要迭代最近点(ICP)构造图和图SLAM来执行构成地图基础的ptimize图。在静态环境中创建的三维点云地图对于精确定位是非常重要的。因此,静态环境图是通过上述动态对象检测排除被识别为动态对象的点群来构造的。

- 实验

4.1自主移动机器人

在本节中,我们描述了我们在SEQSENSE公司提供的SQ-2基础上开发的名为Infant 2的移动机器人的配置。Infant2有一个差动双轮驱动系统。该机器人的大小为571毫米(宽)*508毫米(长)*1296毫米(高)。它将LiDAR、IMU和轮式编码器作为传感器并采用车载嵌入式pc机对这些传感器和自动驾驶进行算术处理。

图7.人类追踪结果:绿色编号是簇标签

为了证明该系统的有效性,我们尝试了人的跟踪、宽视场3d-lidar的场角评估以及基于形状信息的三维地图构建。

4.2实验结果

跟踪一个人的结果如图7所示。绿色数字是一个附加在集群上的标签。如果标签是相同的,则可以说它被识别为相同的集群。如图所示该方法实现了动态目标的跟踪。

实验的结果如图8所示。一个VelodyneHDL-32e安装在1.3米的高度,一个1.7米高的人被放置在远离传感器1米的地方。此外,我们开发的传感器安装在1.2米的高度,而且不是HDL-32e。就像你从图8上看到的,该传感器可以观测到用HDL-32E无法观测的人的整体图像。

图8为在M.U.大学校园D楼周围进行的构建实验三维地图的结果。图8左边是在实验中构建的D楼周围的三维地图全貌。此外,由我们的LiDAR(B)构造的三维地图由HDL-32E(C)构造的地图分别如图9,图10,图11所示。它们在整个地图中X所指示的范围内。从图8可以清楚地看到三维地图的效果。由我们的LiDAR中断,包含在地图上的形状,是不容易受动态对象的影响,而不是由HDL-32e构建的地图。图9是一幅不考虑动态障碍的存在的环境图。图10是排除动态障碍的环境图。结果表明,该方法去除了动态障碍物的运动轨迹。因此,它是可取的预告地图。

图8.视角(左:hdl-32e,右:宽视场LiDAR)

- 结论

本文提出了一种基于三维-LiDAR的动态目标识别方法。该方法实现了动态障碍物的识别和去除。它促成了绘制所需的三维地图。因此,您可以将这种LiDAR和方法应用于导航系统,以提高自主驾驶性能。

参考文献

[1] Neuhaus, F., Dillenberger, D., Pellenz, J., and Paulus,D. ”Terrain drivability analysis in 3D laser range data for autonomous robot navigation in unstructured environments” In Emerging Technologies and Factory Automation, ETFA 2009. IEEE Conference,

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[21107],资料为PDF文档或Word文档,PDF文档可免费转换为Word