英语原文共 6 页,剩余内容已隐藏,支付完成后下载完整资料

外文翻译

题 目 EMOSIC-基于情感的Android音乐播放器

作 者 Karthik Subramanian Nathanlowast;,Manasi Arundagger;和Megala S KannanDagger;

发表时间_____2017年_______

二O 一九 年 四 月 二十五 日

摘要:音乐在人类j的日常生活和现代先进技术中起着非常重要的作用。通常,用户必须面对手动浏览歌曲播放列表以进行选择的任务。在这里,我们提出了一个高效准确的模型,它将根据用户当前的情绪状态和行为生成播放列表。用于使播放列表生成过程自动化的现有方法计算缓慢,不太准确,有时甚至需要使用诸如EEG或传感器的附加硬件。言语是表达情感,情感和情绪的最古老,最自然的方式,它的处理和处理需要高计算量,时间和成本。该提出的系统基于面部表情的实时提取以及从歌曲中提取音频特征以分类成将自动生成播放列表的特定情绪,使得计算成本相对较低。

关键词:语音处理,机器学习,回归分析,谱分析

1.介绍

使用传统音乐播放器,用户必须手动浏览他的播放列表并选择能够缓和他/她的情绪和情绪体验的歌曲。这项任务是劳动密集型的,个人经常面临着登陆适当的歌曲列表的困境。音频情感识别(AER)和音乐信息检索(MIR)的引入为传统系统提供了一种功能,可以根据不同的情绪类别自动解析播放列表。虽然AER处理基于某些音频特征在各种情绪类别下对音频信号进行分类,但MIR是依赖于探索关键信息并从音频信号中提取各种音频特征的字段。虽然AER和MIR增强了它的能力

传统音乐播放器通过根据用户情感消除播放列表和歌曲注释的手动隔离的需要,然而,这些系统没有使用能够使音乐播放器受到人类情感控制的机制。

现有算法不太准确,因为它们产生不可预测的结果,并且经常增加系统的总体存储器开销,使得信息检索算法效率较低。它们无法在最短的时间内从音频信号中提取重要信息。现有的音频情感识别算法采用与用户的感知松散耦合的情绪模型。此外,现有技术被剥夺了设计,能够通过推断由面部图像传达的人类情感来培养定制的播放列表,而不会耗尽额外的资源。现有设计要么使用额外的硬件(如EEG系统和传感器),要么使用人类语音。

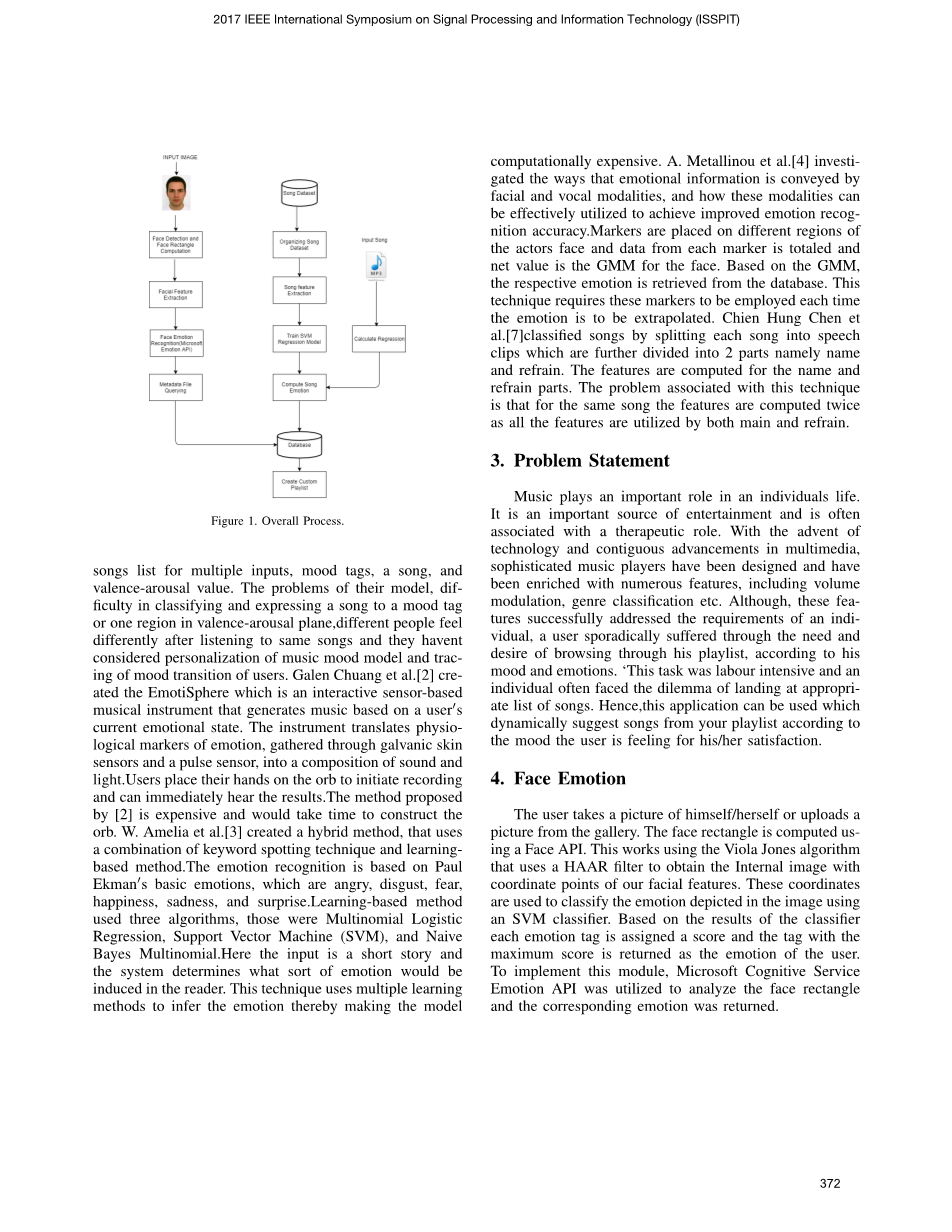

因此,本文提出了一种旨在最大限度地减少现有技术的缺点和缺点的方法。本文的基本目标是设计一种准确的算法,该算法将根据用户的情绪状态产生来自用户播放列表的歌曲列表。所设计的算法需要较少的计算时间,存储并降低了使用附加硬件所产生的成本。它将面部图像分为4种不同的面部表情。悲伤,愤怒,中立和幸福。整个过程如图1所示。

图1

2. 相关文献

Jung Hyun Kim等人[1]使用情绪模型创建基于概率的音乐情绪模型和音乐推荐系统的实现。他们的模型可以表达一首歌的复杂情绪并产生类似的情感多个输入,情绪标签,歌曲和价值唤醒值的歌曲列表。他们的模型存在问题,难以对情绪标签进行分类和表达,或者在价值 - 觉醒平面中表达一个区域,不同的人在听完相同的歌曲后感觉不同,他们没有考虑音乐情绪模型的个性化和情绪转变的追踪。用户。Galen Chuang等人[2]创造了EmotiSphere,这是一种基于互动传感器的乐器,可根据用户j当前的情绪状态生成音乐。该仪器将通过电流皮肤传感器和脉冲传感器收集的情感生理标记转换为声光组合。用户将手放在球体上以开始记录并立即听到结果。[2]提出的方法是昂贵的,需要时间来构建球体。W. Amelia等人[3]创造了一种混合方法,它使用关键词定位技术和基于学习的方法相结合。情绪识别基于Paul Ekmanj的基本情绪,即愤怒,厌恶,恐惧,快乐,悲伤和惊奇。学习基于三种算法,包括多项Logistic回归,支持向量机(SVM)和朴素贝叶斯多项式。这里输入是一个短篇小说,系统决定读者会引起什么样的情绪。该技术使用多种学习方法来推断情绪,从而制作模型

计算上很昂贵。A. Metallinou等人[4]研究了面部和声音模态传达情感信息的方式,以及如何有效利用这些模态来提高情绪识别的准确性。漫画者被放置在演员面部的不同区域,每个标记的数据总和,净值为脸部的GMM。基于GMM,从数据库中检索相应的情绪。这种技术需要在每次外推情感时使用这些标记。Chien Hung Chen等人[7]通过将每首歌曲分成语音片段对歌曲进行分类,这些歌曲进一步分为名称和副词两部分。为名称和副部件计算要素。与此技术相关的问题是,对于同一首歌曲,特征被计算两次,因为主要和副歌都使用了所有特征。

3.问题陈述

音乐在个人生活中起着重要作用。它是娱乐的重要来源,通常与治疗作用有关。随着技术的出现和多媒体的连续进步,复杂的音乐播放器已经被设计并且已经丰富了许多功能,包括音量调制,类型分类等。虽然这些功能成功地满足了个人的需求,但是用户偶尔也会遇到困难。根据他的情绪和情绪浏览他的播放列表的需要和愿望。“这项任务是劳动密集型的,一个人经常面临着在适当的歌曲列表中登陆的困境。因此,可以使用此应用程序根据用户对他/她的满意度感受的情绪动态地建议播放列表中的歌曲。

- 歌曲情感分析

本文中实现的功能如表1所示。

表1 短期和中期特征

|

特征 |

时间 |

频率 |

|

茨克尔 |

|

( |

|

能源 |

|

( |

|

光谱 形心 |

( |

|

|

光谱 传播 |

( |

|

|

光谱 熵 |

( |

|

|

光谱 助焊剂 |

( |

|

4.1 特征提取

4.1.1短期和中期分析

可以在短期基础上提取上述特征列表:首先将音频信号分成短期窗口(帧),并且对于每个帧,计算8个特征。时域特征包括以下内容:

过零率是在特定帧的持续时间内信号的符号变化率。能量是信号值的平方和,由相应的帧长度归一化。频域音频特征包括光谱质心,它是光谱的中心。它表示光谱的“质心”所在的位置。它被计算为信号中存在的频率的加权平均值,使用傅立叶变换确定,其幅度为权重。Spectral Spread是第二个光谱滚降,Spectral Entropy是一组子帧的归一化光谱能量的熵,而Spectral Flux是规范的归一化幅度之间的平方差。两个连续帧的tra。这导致一系列每个8个元素的短期特征向量。广泛认可的短窗尺寸范围为20至100毫秒。这两个重叠帧步骤比帧长度短或不重叠(帧步长等于帧长度)实现成帧。结果存储为一系列特征向量作为结果矩阵。最后,它们被转换为Melscale。通过应用Mel频率滤波器组来获得MFCC。

4.1.2节奏分析

自动节拍感应,即确定音乐节拍速度的任务是一项相当重要的任务,特别是对于音乐信息检索应用的情况。一种直接的速度计算方法已经实现,它采用局部最大值检测程序,应用于一组短期特征序列。连续局部最大值之间的时间距离的集合也是计算并且其最大元素对应于连续节拍之间的最主要时间距离。最后,该检测值用于计算BPM速率。除此之外,短期谐波比和音高以及音频的关键是为了分析歌曲而计算的附加特征。找到音高的方法是比自相关方法更有效的差函数。

4.2 回归

在给定相应的特征向量的情况下,回归是估计未知变量(而不是不同的类标签)的值的任务。它在音频分析应用程序的上下文中也是相当重要的,如果存在从音频特征到像语音情感估计那样的实值变量的映射,其中情绪不是由离散类表示的(例如,愤怒,幸福,等)但通过维度表示(egValence- 觉醒)。系统支持SVM回归训练,以便将音频特征映射到一个或多个监督变量。为了训练音频回归模型,用户应该提供一系列存储的音频片段。

在同一文件夹中单独的文件。在均方误差(MSE)的帮助下,在回归训练过程的背景下最大化性能测量。除此之外,对于每个测试参数值,还计算训练数据的MSE以提供过度拟合数据的度量。

4.3 Valence觉醒平面

价值唤醒坐标系在x轴上具有Valence,在y轴上具有唤醒。Valence,如心理学中使用的,特别是在讨论情绪时,意味着事件,对象或情境的内在吸引力/“好” - 性(正效价)或厌恶/“坏” - (负价)。术语是也用于表征和分类特定的情绪。例如,通常被称为“消极”的情绪,例如愤怒和恐惧,具有“负价”。乔伊有“积极的价值”。唤醒是被唤醒的生理和心理状态或被感知刺激到感知点的感觉器官。它涉及激活大脑中的上行网状激活系统(ARAS),其介导觉醒,自主神经系统和内分泌系统,导致心率和血压增加以及感觉警觉,活动和准备状态。响应。每个象限都具有基于从歌曲分析中获得的Valence-Arousal值的特定情绪。该坐标系用于将Valence-Arousal值直接映射到其各自的情绪中,从而为每首歌曲提供情感标记。图2显示了Valence-Arousal平面。

图2

- 结果

从[5],支持向量机(SVM),随机森林分类器和[6] KNN(K-Nearest Neighbors)中选择。对于提取的特征,应用算法并计算MSE(均方误差)。基于MSE,算法被相应地排序。从[8]可以推断,当在表2中验证的语音特征上实现时,神经网络(nn)表现不佳。表2中示出了MSE和R2。从表2中可以清楚地看出,SVM提供了最小的MSE和最高的R2得分,使其成为回归的最佳算法。由于SVM提供了最佳性能,因此选择了另一个线性模型脊回归器,从表中可以推断出它提供了第二好的性能。该算法应用于48首歌曲,得到的结果如表4所示。根据图2所示的Valence-Arousal坐标系统绘制情感。数据集由50个声音样本组成,其效价和唤醒值已知。这些语音样本采用wav格式。因此,每首mp3歌曲都需要转换为.wav格式。对于48首歌曲,计算歌曲的价值和觉醒所花费的平均时间是54秒,因为每首歌曲需要从mp3转换为wav格式,之后计算特征。此外,可以看出,与每首歌曲相关联的情感标签与歌曲j的实际情感不同,因为没有考虑歌曲的含义,即仅分析语音信号。Emotion标签根据表3分配。

表2.分类器的mse和r2

|

SVM |

随机森林 |

Knn |

RidgeRegressor |

恩恩 |

|

|

MSE |

0.12 |

0.20 |

0.28 |

0.19 |

0.35 |

|

R2 |

0.79 |

0.41 |

0.21 |

0.45 |

0.19 |

表3.情绪映射

|

情感标签 |

觉醒 |

价 |

|

快乐 |

已经 |

已经 |

|

中性 |

-我的工作 |

已经 |

|

愤怒 |

已经 |

-我的工作 |

|

伤心 |

-我的工作 |

-我的工作 |

表4.对歌曲和相应情绪执行的支持向量回归

|

歌曲 |

觉醒 |

价 |

情感 |

|

破碎球 |

0.024 |

0.096 |

快乐 |

|

破灭的梦想 |

0.124 |

-0.236 |

愤怒 |

|

遭受 |

剩余内容已隐藏,支付完成后下载完整资料 资料编号:[20786],资料为PDF文档或Word文档,PDF文档可免费转换为Word |