英语原文共 10 页,剩余内容已隐藏,支付完成后下载完整资料

用于图像分类的多路径特征重定标DenseNet

摘要:

近年来,深度神经网络在图像分类任务中表现出了良好的效率,通常是通过扩展网络结构的深度和宽度来实现的。然而,这种综合架构可能会导致收敛性差、过拟合和梯度消失等问题。因此,开发DenseNet来解决这些问题。虽然DenseNet在DenseBlocks中采用了瓶颈技术,以避免重新学习特征映射和减少参数,但这种操作可能会导致重要特征的跳过和丢失。此外,为了更好地分类,当网络结构的深度和宽度增加时,仍然需要超大的计算能力。在本文中,我们提出了一个变量的DenseNet,称为Multipath Feature Recalibration DenseNet (MFR-DenseNet),以叠加卷积层,而不是采用瓶颈来改进特征提取。同时,我们利用挤压-激励(SE)模块构建了多路径致密块,以表示不同致密块之间有用特征映射的相互依赖关系。在CIFAR-10、CIFAR-100、MNIST和SVHN上的实验显示了我们的网络的效率,在保持DenseNet的高精确度的同时,进一步减少了冗余。

关键词:密集网,图像分类,多径密集块,特征重标定,mfr -DenseNet

1、介绍

近年来,由于硬件设备的改进,卷积神经网络(CNNs)正在向网络架构的深度和宽度扩展。从AlexNet[1]到VGGNet[2],以及GoogleNet[3]、Highway[4]和ResNet [5],CNNs的深度和宽度都在不断增加,这有助于在图像分类任务中取得优异的性能。

但相关研究[3,6,7]表明,综合网络结构可能会产生收敛性差、过拟合、梯度消失等缺点。为了缓解这些问题并鼓励特性传播、重用,DenseNet[8]允许各层访问来自所有先前层的特性映射。

DenseNet[8]是现有最深的CNNs之一,主要由DenseBlocks(提取和传播特征图)和过渡层(连接两个相邻的DenseBlocks)组成。尽管DenseNet由于其密集的连通性和深度结构取得了显著的成果,但仍存在一些不足之处。首先,DenseNet简单地在DenseBlocks中采用瓶颈模块,在过渡层中采用降维技术来降低参数。但这些操作可能会导致重要特征图的跳过和丢失。因此,如果进一步改善瓶颈的相关结构和维度,将会加强特征提取和重用。其次,特征映射的相关性没有明确建模。通过建模不同维度和不同网络路径的特征映射,有利于自适应地学习相关系数。这些存在的缺点与DenseNet在分类精度、资源占用、训练时间和内存消耗方面的性能有很大的关系。

为了达到全方位的性能,学者们从DenseNet开始对这些现有的问题做了进一步的改进,提出了许多新的架构。稀疏DenseNet (SparseNet)[9]以参数效率和计算效率更高的方式减少了l层DenseNet的连接。此外,SparseNet还引入了一个关注模块,进一步提高了SparseNet的性能。Zhang等人[10]在SE模块的基础上提出了多特征重权重DenseNet用于图像分类,但该网络并没有很好地聚焦冗余和消耗。文献[11]提出了利用快捷连接连接DenseNet和解调卷积来提高网络训练速度的DD-Net,但它占用了更多的资源。此外,提出了双路径网络(DPN)[12]来改进特征表示。它可以有效地结合ResNet的特征重用和DenseNet的新特征探索,但大大增加了体系结构的复杂性。Lodhi和Jaewoo[13]提出了一种新的Multipath DenseNet,它采用监督独立的浅层模块和多路径块来增加梯度流的路径数量。Multipath DenseNet可以有效地减缓训练时间,但不能显著提高精度。需要注意的是,Huang等人开发了CondenseNet[14],通过群卷积和剪枝来减少内存占用,加快训练速度操作,但分类精度没有明显提高。

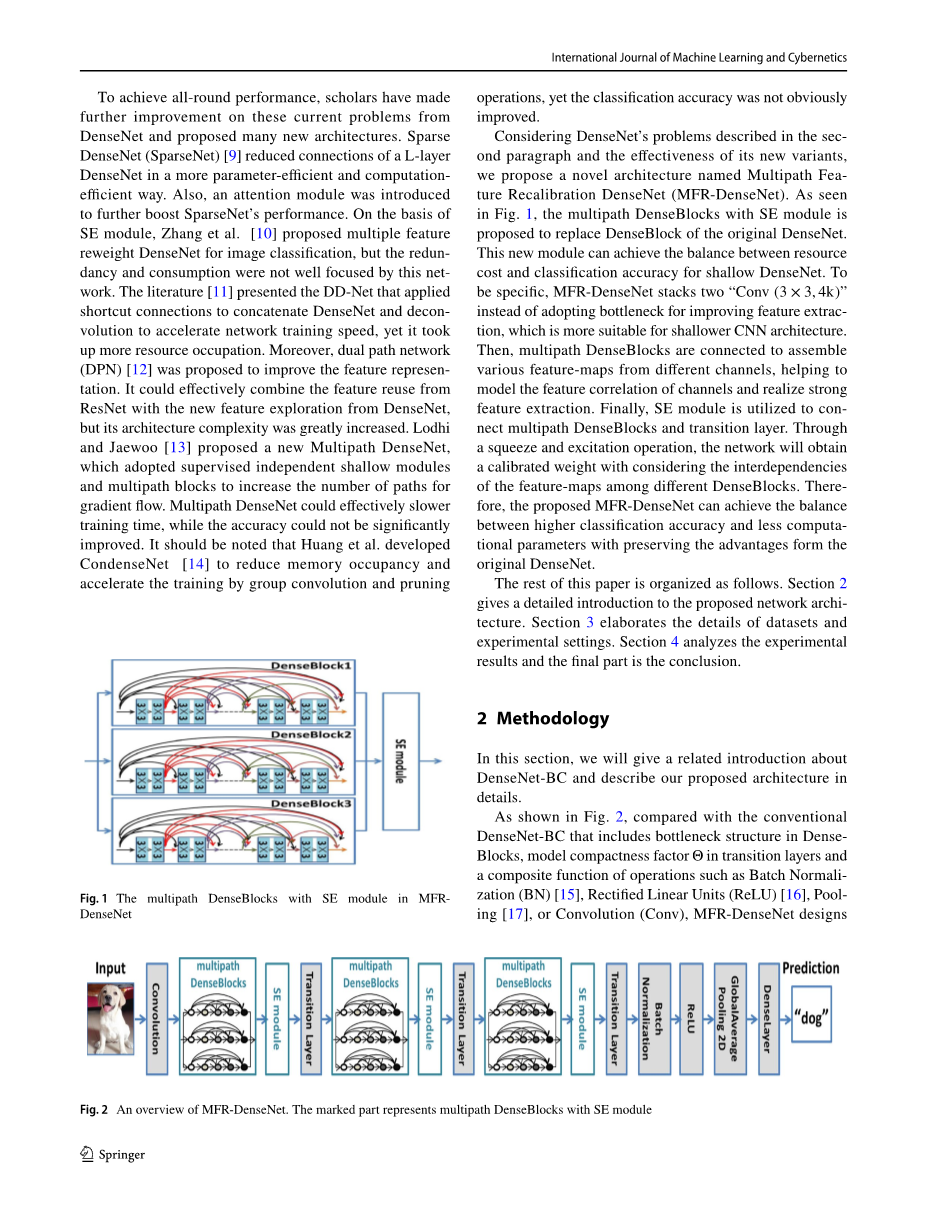

考虑到第二段中描述的DenseNet问题以及其新变体的有效性,我们提出了一种新的体系结构,称为多径特性重校准DenseNet (MFR-DenseNet)。如图1所示,我们提出用带有SE模块的多径DenseBlocks来替代原来DenseNet的DenseBlocks。该模块可以实现浅层DenseNet的资源成本和分类精度之间的平衡。MFR-DenseNet将两个“Conv (3 times; 3,4k)”叠加在一起,而不是采用瓶颈来改进特征提取,更适合于较浅的CNN架构。然后,将多径密度块连接起来,组装来自不同信道的各种特征图,有助于建模信道的特征相关性,实现强特征提取。最后,利用SE模块连接多径密度块和过渡层。通过挤压和激励操作,该网络将考虑不同密度块之间的特征映射的相互依赖性,获得一个标定的权重。因此,本文提出的MFR-DenseNet可以在保持原始DenseNet优势的同时,在较高的分类精度和较少的计算参数之间取得平衡。

本文的其余部分组织如下。第二节详细介绍了所提出的网络结构。第三节详细阐述了数据集和实验设置的细节。第四部分对实验结果进行分析,最后是结论部分。

2、方法

在本节中,我们将对DenseNet-BC进行相关介绍,并详细描述我们提出的体系结构。

如图2所示,与传统的DenseNet-BC相比,MFR-DenseNet设计包括密集块中的瓶颈结构,过渡层中的模型紧凑度因子Theta;和批量归一化(BN)[15],修正线性单元(ReLU)[16],池[17],或卷积(Conv)等操作的复合函数用SE模块代替原来的DenseBlock。具体结构介绍如下:

2.1 DenseNet -BC

在[8]文献中,Huang等人提出了DenseNet的三种结构:DenseNet、DenseNet- B和DenseNet- BC。这些结构之间的具体差别如下:

首先,DenseNet主要包括由“BN ReLU Conv (3 times;3,4k)”组成的DenseBlock和由“BN ReLU Conv (1 times; 1, k) Polling(2times;2)”组成的过渡层。其次,在原始DenseNet的基础上,DenseNet-B在DenseBlock中增加了“BN ReLU Conv (1times;1, k)”。也就是说,DenseNet-B的DenseBlock由“BN ReLU Conv (3times; 3,4k) BN ReLU Conv (1times;1, k)”组成。最后,在DenseNet- BC的基础上,DenseNet- BC在过渡层引入了模型紧凑性因子Theta; = 0.5,即DenseNet- BC的过渡层由“BN ReLU Conv (1times;1,Theta;k) Pooling (2times;2)”组成。因此,与DenseNet和DenseNet- B相比,DenseNet- BC可以由于瓶颈和模型紧凑性因素而减少大量的参数。

2.2 卷积堆栈

瓶颈结构作为改变特征通道维度的重要手段,自2014年GoogleNet[3]首次提出以来,在CNNs中得到广泛应用。DenseNet-BC也采用这种结构来降低通道维数,减少参数,提高非线性表达能力。而瓶颈处的卷积运算和信道降维决定了特征提取的能力。这意味着DenseNet-BC的原始瓶颈缺乏较强的特征提取能力,不考虑重要的特征映射。因此,分类精度会大大降低。为了进一步缓解这种较差的特征提取问题,需要对DenseNet的深度和宽度进行扩展,但这种操作会增加计算设备的负担。因此,应该考虑一个新的结构为更好的特征提取和图像分类提供合理的资源成本。

在ResNet-34[5]中,采用卷积堆栈技术提取特征映射。假设卷积层的输入输出特征映射大小与C相同,则DenseNet- BC中一个瓶颈的参数如式(1)所示:

1times;1times;Ctimes;Ctimes;4k 3times;3times;Ctimes;Ctimes;k=13kC^2,(1)

而两个叠加的“Conv(3 times; 3,4k)”的参数如式2所示:

3times;3times;Ctimes;Ctimes;4k 3times;3times;Ctimes;Ctimes;4k=72kC^2,(2)

原有的瓶颈可以通过将信道维数从4k降低到k来有效地减少参数,而叠加两个“Conv (3 times; 3,4k)”会由于信道的增加和卷积核的改变而增加更多的参数。尽管参数不断增加,但对于层数较少的网络,该模块将使其更具非线性、决定性和正则性。此外,其有限接收域的大小与单个“5times;5”卷积相同,具有较强的特征提取能力。如式(3)所示,卷积堆栈的每一个输出表示为:

xn=T1(xn-1),(3)

其中xn表示除x0外的第n个卷积堆栈,并且Tl(.)表示非线性变化的输出。

为了验证上述两种结构的有效性结构,我们进行了一些由CIFAR-10中的原始DenseNet-BC训练的预实验。网络训练的时代只有10年,评估指标包括浮点运算每秒(即FLOPs),参数(即Params)和测试错误率。如表1所示,实验结果表明,与瓶颈算法相比,卷积堆栈占用更多的资源成本,但特征提取能力明显提高,测试错误率显著降低。同样的参数设置,如d = 16和k = 4,原DenseNet-BC “Conv(1times;1,4 k) Conv(3times;3 k)”的分类测试错误率比与“Conv(3times;3,4 k) Conv(3times;3,4 k)”。具体来说,尽管带有卷积栈的DenseNet-BC可以引起更多的模型开销,在相同参数设置下,CIFAR-10的测试错误率降低是非常出色的。此外,卷积叠加有利于原DenseNet-BC降低深度和增长率,从而实现参数的降低。以“Conv(1 times; 1,4k) Conv(3 times; 3,k)”(d = 64,k = 8)和“Conv(3 times; 3,4k) Conv(3 times; 3,4k)”(d = 34,k = 6)为例,模型成本和分类精度接近。因此,对于shallow CNNs来说,卷积堆栈能够更有效地实现模型成本与精度之间的平衡。

2.3 多路径DenseBlocks

在CNNs中采用卷积运算时,有些特征图并没有完全提取出来。因此,特征映射的相关性没有明确建模,极大地影响了网络性能。通过将卷积栈改进的密集块级联,设计了一个新的多路径密集块模块。它可以将不同通道的各种特征图集合起来,发现这些特征图之间的相关性,避免丢失重要的特征图。此外,多路径DenseBlocks可以改善DenseBlocks之间的密集连接,因此它将进一步减小DenseNet的宽度和深度,缓解与深度结构相关的问题。

如式(4)所示,单层l层稠密块的输出为yl,表示如下:

其中Hl(.)表示一个非线性变换,并且 [x0, x1, ..., xl-1] 指的是在约定栈0,hellip;,lminus;1中产生的特征映射的拼接。

如式(5)所示,由并行的DenseBlock组成的多路径DenseBlocks如下所示:

Yj是多路径DenseBlocks和yln的输出表示第n个DenseBlock的输出。

为了实现多径密集块的最佳效果,避免产生额外的冗余,进一步确定了密集块的数量。在CIFAR-10中训练的预实验中,提出的MFR-DenseNet的深度和增长率分别为64和8。此外,网络训练的时代只有10年,评估指标包括失败次数、参数、模型记忆以及测试错误率。如图3所示,当DenseBlock的数量从1逐渐增加到10时,与FLOPs、Params和模型内存相关的模型成本严重增加,而测试错误率无法实现持续下降。因此,合适的DenseBlock数量对于平衡模型开销和分类精度非常重要。预实验结果表明,当DenseBlock数量在2 ~ 4之间时,模型成本与分类精度之间的平衡是最优的。假设将DenseBlock的数字ber从2提高到3,测试错误率从11.66降低到11.32%,降低0.34%,模型成本略有上升。对于4个级联致密块,由于额外的成本有一定的增加,但测试错误率可以从11.32下降到11.09%,下降了0.23%。上述预实验结果和分析表明,当DenseBlock个数为3时,特征提取能力较好,模型成本相对合理。因此,本文采用3个级联的Denseblock组成多径Denseblock。

2.4 SE模块

文献[18]说明SE模块可以嵌入在ResNet的残差模块之后。它能达到较好的分类效果,降低计算复杂度。基于DenseNet和ResNet的相似性,将SE模块嵌入到MFR-DenseNet中的多径DenseBlocks之后,如图4所示。通过挤压和激励运行时,网络将自动学习每个特征通道的标定权重。该校准权重可以考虑特征映射的相互依赖性在不同DenseBlocks。因此,它可以增强有用特性和抑制无用特性,用于当前任务。多径密度块的输出特征映射为首先通过挤压操作,将其聚合特征映射跨越不同的密度块,并将这些特征Yj从每个二维特征映射(即Htimes;W)转换为通道描述符。这是通过使用全球平均池生成渠道相关的统计信息。形式上,挤压过程计算如式(6)所示:

接下来是激励操作,它包括并为每个通道生成权值。当Y`j作为激励功的输入时,输出S可由式(7)得到:

其中delta;是ReLU函数,sigma;是Sigmoid函数。此外,

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[589772],资料为PDF文档或Word文档,PDF文档可免费转换为Word