英语原文共 16 页,剩余内容已隐藏,支付完成后下载完整资料

实验与理论人工智能学报 2013年 第25刊 No. 4 425–439

在线评论的中文情感分类的文本特征选择

作者:Hongwei Wang, Pei Yin, Jiani Yao and James N.K. Liu

地点:同济大学经济管理学院,上海市四平路1239号200092; 中国香港理工大学计算系

(2012年3月11日定初版本,2012年8月12号收到最终版本)

为满足网络社区定制服务的要求,在线评论的情感分类已经被应用于非结构化评论,使用户对这些产品的观点显得更加明确。本文的目的是:提出针对在线评论在传统文本分类方法中使用中文情感分类作为分类特征的技术。首先,形容词,副词和动词包含个人情绪信息,以此作为潜在的文本特征。然后,本方案选择4个统计方法:文件频率(DF),信息增益(IG),卡方统计学(CHI)和互信息(MI)用于选择文本特征,使用布尔加权法用于设置权重和构造向量空间模型。最后,使用支持向量机(SVM)分类器用于预测在线评论的情感极性。我们以酒店在线评论为数据,以不同统计方法为实验组别,进行了若干组比较实验。结果表明,以形容词、副词、动词作为特征来实现中文情感分类准确度最高。此外,不同的特征选择方法也有不同的情感分类序列,其中以DF统计的词作为文本特征结果组表现最好,紧随的是CHI统计组,以及IG统计组。最后,我们发现MI不适合中文在线评论的情感分类。该结论有助于提高情感分类的准确性和下一步的研究。

关键词:特征选择方法;文本分类;情感分类;中文在线评论。

- 背景介绍

随着web 2.0的快速发展,人们越来越多的参与到网络沟通中。越来越多的人想通过各种在线社交媒体,特别是电子商务网站提供的留言板,分享他们对某些产品的评价。 然而,大多数电子商务网站低估了在线评论的价值,因此他们的分析工具不足以满足客户的个性化需求。 因此,根据定制服务的要求,自动识别和评估情感信息的在线评论情感分类需求持续上升。

与传统文本分类不同,传统的文本分类集中在确定文本主题(例如运动和电影)中,所谓在线评论的情感分类是识别和分类客户对非结构化文本的意见,也称为情感极性,即“正面”或“负面”。选择具有某些情感信息的文本功能以帮助区分在线评论的情感极性。例如,“我喜欢这台相机”中的“爱”明确表示了这次审查的积极情绪。特征选择的现有研究主要是针对文本分类而不是情感分类,其中大多数都集中在挖掘英语在线评论。由于中英文语言结构和文化背景的差异,中国人具有独特的情感表达方式,使得英语在线评论的情感分类研究成果无法直接应用于中文。因此,本研究的主要目标是选择文字特征,改善中国在线评论情绪分类。

本文其余部分组织如下:我们将在第二章回顾参考文献;在第三节中介绍情感分类方法;第四节中,我们将对中文在线评论的情感分类进行的实验进行评估。最后,我们将在第五章总结并展望后续研究。

-

相关文献

- 情感分类的基本过程

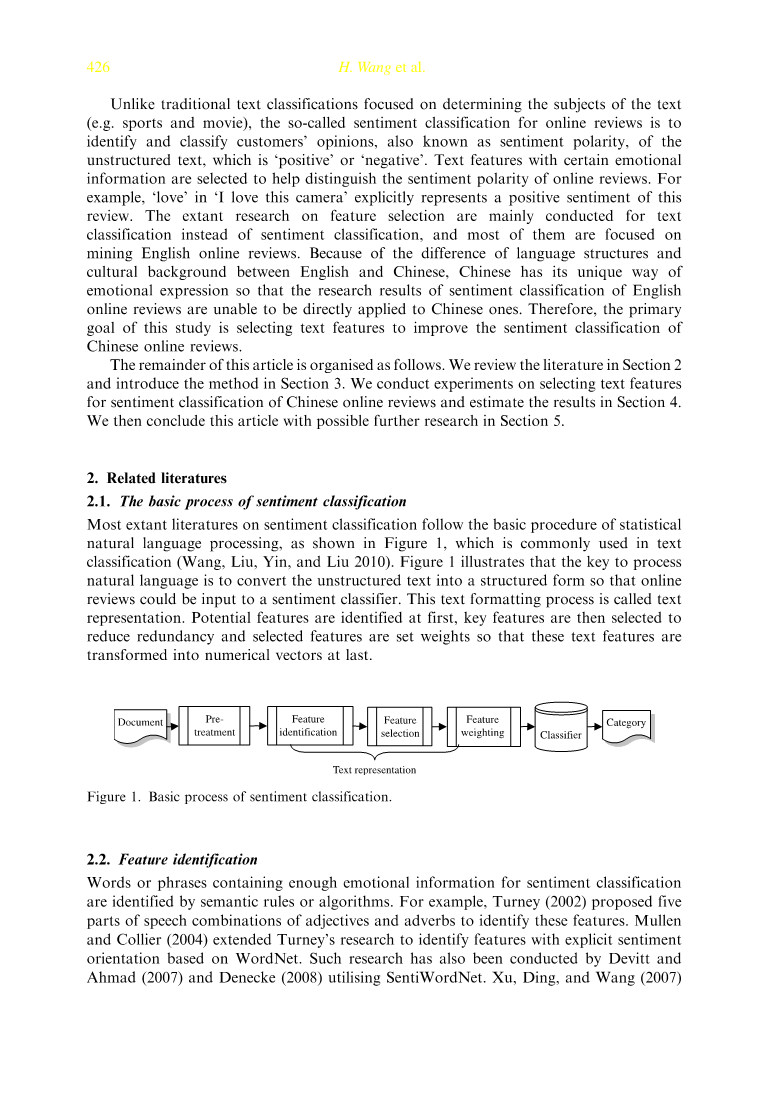

情感分类的大多数现有文献遵循统计自然语言处理的基本过程,如图1所示,这在文本分类中是常用的 (Wang,Liu,Yin和Liu 2010)。 图1示出了处理自然语言的关键是将非结构化文本转换成结构化形式,以便在线评论可以输入到情感分类器。 此文本格式化过程称为文本表示。 首先识别潜在特征,然后选择关键特征以减少冗余,并且选择的特征时设置权重,使得最后将这些文本特征变换成数字向量。

图1情感分类的基本过程

2.2 特征识别

通过语义规则或算法识别包含情绪分类的足够情绪信息的单词或短语。例如,Turney(2002)提出了形容词和副词的五部分词性组合来识别这些特征。 Mullen和Collier(2004)扩展了Turney的研究,以基于WordNet的识别具有明确情绪导向的功能。 Devitt和Ahmad(2007)和Denecke(2008)利用SentiWordNet进行了同样的研究。 Xu,Ding和Wang(2007)使用朴素贝叶斯(NB)和最大熵模型分析新闻评论,并得出结论认为,具有明确情绪导向的词,特别是形容词和名词对情绪分类具有关键影响。 Abbasi,Chen和Salem(2008)将遗传算法与信息增益(IG)启发式相结合,并开发了用于特征识别的“加权遗传算法”。 Zhou,Lin和Li(2010)比较了名词和动词的组合以及形容词和副词的组合,结果表明前一种组合实现了更好的分类表现。Zhao, Qin, Che和 Liu(2010)使用自动选择的句法路径来识别情感分类的特征。 Zhang,Ye,Zhang和Li(2011)采用n-gram方法识别特征。 Abbasi,Zhang和Chen(2011)通过考虑语义信息与n-gram特征之间的句法关系,提出了一种称为“特征关系网络”的基于规则的多变量文本特征识别方法。

-

- 特征选择

一些统计学方法,如互信息(MI),卡方统计(CHI),文献频率(DF),IG,术语强度(TS),预期交叉熵(ECE),文本证据的权重(WET)、优势比(OR)和“随机”都可用来选择文本分类的特征。基本思想是评估每个功能,并删除比阈值小的特征。例如,Yang和Pedersen(1997)比较了MI,CHI,DF,IG和TS的五种特征选择方法,比较了DF,IG,和CHI的特征值,发现DF,IG和CHI具有相似的分类结果。此外,TS表现优于MI。 Mladenic和Grobelnik(1999)比较了OR,IG,DF,ECE,MI,随机和WET,结果表明OR表现最好,MI表现最差。Qin, Chen, Wang和Lu(2003)比较了MI,CHI,ECE和WET,结果表明MI表现最好,ECE表现最差。Zhou, Zhou和Hu(2004)比较了DF,IG,CHI,ECE,WET和OR,并表示OR表现最好,DF表现最差。 Ng,Goh和Low(1997)比较了DF,MI,IG和CHI,并认为CHI表现最好,而DF和IG表现优于MI。相反,Tang, Tan, Cheng(2007)以及Yao, Wang和Yin(2011)也比较了四种特征选择方法(DF,MI,IG和CHI),但两者结果表明,IG表现最好情绪分类。

-

- 特征权重

特征加权方法主要有布尔权重,项目频率(TF),逆文档频率(IDF)和TF-IDF)。 例如,庞,李和Vaithyanathan(2002)将布尔权重应用于情绪分类,准确率达到82.9%。 结果表明,积极或消极的情绪取决于特征是否出现而不是频率。 换句话说,它是表达情感的功能,而无关乎它出现的次数。 Wei,Miao,Chauchat和Zhong(2008)使用不同的n-gram特征(1,2克或1,2和3克)来表示文本,并使用TF来加权特征。

-

- 选择分类器

通常用于文本分类的分类器包括支持向量机(SVM),最大熵(ME),NB等,大量的研究表明SVM具有文本分类的主导权力,特别是在有限的训练的情况下样本(Ye,Qin和Li 2005)。例如,Pang et al(2002)比较了三个分类器NB,ME和SVM,结果表明SVM表现最好。 Shi,Qi,Meng(2005)利用SVM比较中英文书评情绪分类,结果表明SVM在中文评论中表现优异。Jiang(2006)采用SVM对144个电影评论的情感极性进行分类,得出准确度为85.4%。Tang等(2007)认为SVM是比K-Nearest Neighbor,Winnow和NB更好的分类器。 Ni,Xue,Ling,Yu和Yang(2007)指出,与NB和ME相比,SVM表现最好。Xia和Peng(2009)采用SVM进行酒店评论的情感分类,得出结论,随着评论数量的增加,精度提高。 Ye,Zhang和Law(2009)根据旅游博客的评论将SVM与NB进行了比较,发现SVM优于NB。此外,由Phienthrakul,Kijsirikul,Takamura和Okumura(2009)持有的SVM的核函数的研究表明,核函数的精度有助于提高分类精度,多项式核表现优于单核。 Zhang,Ye,Law和Li(2009)指出,基于汉语中文分词工具的SVM分类器对在线粤语评论的情感分类表现出色。

-

- 对相关文献的总结

一般来说,有关特征选择的相关文献主要是为了预测文本的主题,也被称为面向主题的文本分类,而很少是针对在线评论的情感分类。 而且,大多数人正在研究的是英文文本(,其方法对中文情感分类的借鉴意义不大)。 因此,本文的目的是运用良好的文本分类方法,对中文在线评论的情感分类进行更有效的选择。

- 特征选择方法

3.1 文本格式

本文提出的特征选择方法使用通常用于文本分类的向量空间模型来格式化在线评论,并帮助分类器识别非结构化文本。 主要思想是用一定数量的选定功能来表示每一张评论。 假设特征序列为{f1,f2,...,fn},并且复查表示为:r = {w1,w2,...,wn},其中,fin,fi和wi分别表示数量 所选择的特征,第i个选定的特征及其权重fi(也是所选特征的值)。 因此,该过程有三个主要步骤:特征识别,特征选择和特征加权。

3.2 特征识别

文本特征包含足够的文本表示和情感分类的情感信息,因此它们不仅应该准确地表达审查的意义,而且还应该将评论的情感极性相互区分开来。把中文在线评论中的单字,单词和短语作比较:单词包含比单个字符更丰富的情感和更多的信息,并且比短语更容易识别。因此,词被认为是文本特征。

一些现有的研究根据情绪词典或句法规则来识别特征,但是它们是十分复杂的并且依赖于外部来源。 因此,本文仅仅使用文本中(重要)的一部分来作为识别特征。

特征识别过程如下。 首先,每个在线评论是分开成句,再将句子分割成词组。 然后,对每个词组(例如名词,动词,形容词,副词)产生部分词性标签。 之后,删除对情绪分类没有贡献的词,如停止词(例如(of))。 最后,形容词,副词和动词被识别为初始文本特征。 此外,应该指出,接近形容词或动词的负面话语也被视为特征。 例如,在这个评论中:“我不喜欢这个房间有不舒服的气味。”,“不喜欢”和“不舒服”被识别为特征。 此外,像“有”和“没有”这样的辅助词也被认为是特征。

3.3特征选择器

特征识别产生巨大的特征集,并创建高维向量空间,这将最终降低情感分类的效率和有效性。因此,选择具有重要情感区分能力的特征并减小矢量空间的维度是至关重要的。引入四种统计方法:DF,IG,CHI和MI来选择特征。

(1)文件频率(DF)

DF表示所有文档(评论)中每个功能发生的次数。具有太低值的功能不足以代表文档,具有太高值的功能不足以区分文档。因此,引入了两个阈值来消除特征集的噪声。

(2)信息增益(IG)

基于熵的IG方法是针对特征提供给情绪分类的信息量来测量某个特征的重要性。信息量由熵(Entropy)确定,用于描述随机事件的不确定性。文件(评价)的熵越大,分类文档的不确定性就越大。因此,具有和不具有某个特征的文档的熵之间的差异表示包含在特征中的信息量。某特征fi的IG值由下式计算:

其中Entropy(S)表示没有特征fi的文档的熵,Entropy(Sfi)表示具有特征fi的文档的熵。P(Cj)表示文档属于Cj的可能性,其中M=2,Cj表示类j,Positive(C1)和Negative(C2)。P(fi)[P(fi)= DF(fi)i / NC,其中DF(fi)表示特征fi发生在所有文档中的次数,NC表示文档的总数,表示某个文件包含特征fi。类似地,P(fi)表示某个文档不包含特征fi的可能性。P(Cj|fi)[ P(Cj|fi)=N(Cj,fi)/DF(fi)],其中N(Cj,fi)表示属于Cj的文档的数量,并且包含特征fi。P(Cj|ti)=N(Cj,ti)/DF(ti)表示在含有特征fi的情况下某个文档属于类Cj的条件可能性,而P(Cj|fi)[ P(Cj|fi)=N(Cj,fi)/DF(fi)](其中N(Cj,fi)表示属于Cj的评论数量,而没有特征fi, P(Cj|ti)=N(Cj,ti)/DF(ti)表示条件可能性,某些文件在不包含特征fiti的条件下属于Cj类。

(3)平均统计

CHI方法测量某个特征fi和类Cj(正或负,j = 2)之间的相关性,并假设fi和Cj适应具有一阶自由度的2次方分布。 CHI值越大,相关性越高,情感区分能力越强。 某个特征fi和Cj的CHI值由下式计算:

其中NC表示文件的总数,N(Cj,fi)表示数量属于Cj的文件并且包含特征fi。 N(Cj,fi(补))表示数字评论属于Cj,没有功能fi。

(4)相互信息(MI)

MI方法的基本思想与CHI方法的基本思想相似某个特征fi与Cj之间的相似性之间的相关性fi和Cj。 使用某一特征fi和类Cj(j = 1,2)的

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[141303],资料为PDF文档或Word文档,PDF文档可免费转换为Word