英语原文共 4 页,剩余内容已隐藏,支付完成后下载完整资料

论句子主题模型

Georgios Balikas,Massih-Reza Amini and Marianne Clausel

University of Grenoble Alpes Computer Science Laboratory (LIG), Applied Mathematics Laboratory (LJK) Grenoble, France

{FirstName.LastName}@imag.fr

摘要:

概率主题模型是通过发现隐含的主题来描述文档的内容的生成模型。然而,文本输入的结构以及例如句子等连贯文本跨度中的单词分组包含许多通常在这些模型中丢失的信息。在本文中,我们提出了句子 LDA模型,一种LDA模型的扩展,其目标是通过将文本的结构并入生成过程和推理过程来克服这个限制。我们通过在不同文本集合上使用内在(困惑)和外部(文本分类)评估任务,将句子LDA与LDA进行比较来说明句子LDA的优点。

关键词:

文本挖掘; 主题建模; 无监督学习

介绍:

统计主题模型是生成式无监督模型,描述大型文本集合中文档的内容。 此前的研究调查了潜在狄利克雷分配(LDA)等主题模型在从图像分析到政治科学等各种领域的应用。 大多数关于主题模型的工作都假设文字之间可交换,并以文字方式处理文档。 因此导致了在连贯的文本片段中,例如句子或短语中的词组丢失。

但是,识别主题时,文档的内部结构通常很有用。 例如,人们会预期,在每个句子中,经过标准预处理步骤(如停用词移除)后,只会出现非常有限的潜在话题。 因此,我们认为连贯的文本片段应该对这些片段内出现的主题数量提出“约束”。

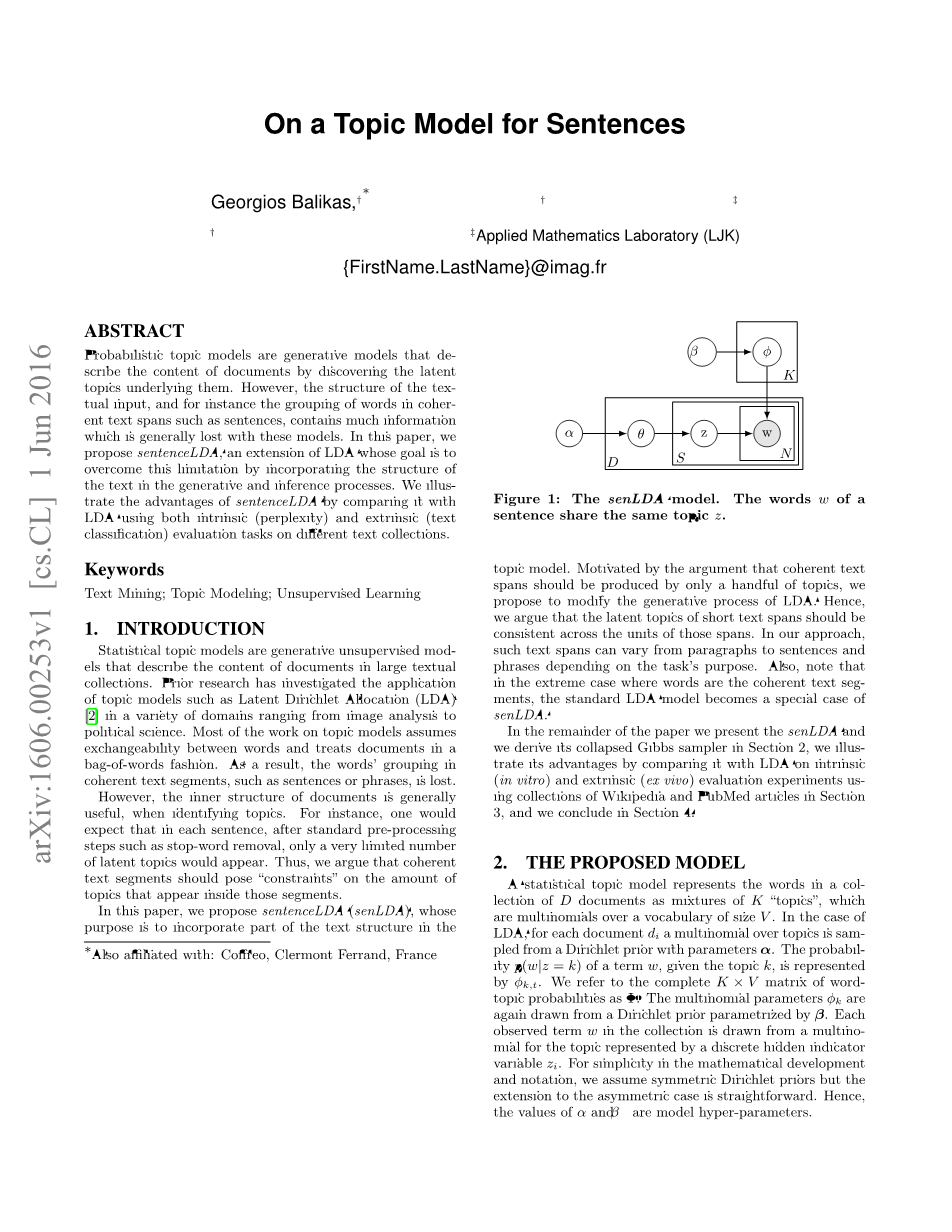

图1:senLDA模型。 一个句子的单词w共享相同的话题z。

在本文中,我们提出了句子LDA(senLDA),其目的是将部分文本结构合并到主题模型中。 由于连贯的文本跨度只能由少数几个主题产生,我们建议修改LDA的生成过程。 因此,我们认为短文本跨度的潜在主题应该跨越这些跨度的单位是一致的。 在我们的方法中,取决于任务的目的,这样的文本跨度可以根据段落到句子和短语而变化。 另外,请注意,在极端情况下,单词是连贯的文本片段,标准LDA模型成为senLDA的特例。

在本文的其余部分中,我们介绍了senLDA,并且我们在第2节中推导了它的折叠吉布斯采样器,我们通过使用维基百科和PubMed文章的集合在第3节中对内在(体外)和外在(离体)评估实验与LDA进行比较来说明其优点,并在第4部分进行总结。

建议模型:

统计主题模型将D文档集合中的单词表示为K个“主题”的混合,这K个主题是大小为V的词汇表上的多项式。在LDA中,对于每个文档di,在参数alpha;之前,先从Dirichlet中对主题进行多项式取样。给定主题k的项w的概率 p(w|z = k) 由Фk,t 表示。我们将词汇主题概率的完整Ktimes;V矩阵称为Phi;。 多项式参数Фk再次由先验的Dirichlet绘制,并由beta;进行参数化。 集合中的每个观测项w都是从离散隐藏指示变量zi表示的主题的多项式中抽取的。 为了简化数学发展和符号,我们假定对称Dirichlet先验,但对不对称情况的扩展是直截了当的。 因此,alpha;和beta;的值是模型超参数。

我们通过添加一个表示文档的连贯文本段的额外板来扩展LDA。 其余的,为了不失去一般性,我们使用句子作为连贯的片段。 通过分析句子的结构和使用短语作为这样的片段,可以实现精细的粒度级别。 在图1中显示了senLDA模型的图形表示,并且在算法1中描述了使用senLDA的文档集合的生成过程。对于推断,我们使用折叠的吉布斯采样方法[5]。我们现在通过以下方式导出吉布斯采样器方程: 估计隐藏的主题变量。

在senLDA中,联合分配可以被分解:

p(w,z|alpha;,beta; ) = p(w|z,beta; )p(z|alpha;) (1)

因为第一项与alpha;无关,第二项与beta;无关。 在像[6]范式那样的标准操作到达后:(2)

其中是用于表示法方便的beta;函数的多维扩展,并且分别指代具有文档和主题的话题的出现。 为了计算完整的条件,我们考虑文档d的结构和的事实。下标分别表示句子s的词和主题。 对于主题k的完整条件,我们有:

(3)

对于方程式(3)的第一项我们有:

(4)

在这里,为了生成A和B,我们使用了Г函数的递归属性:Г(x m) = (x m-1)(x m-2) ···(x 1)x Г(x); w是一个可以在句子中出现多次的词, n(w) k,s 表示句子s中属于主题k的w的频率; N(w) k,s 表示句子s有多少个单词属于主题t。

在方程(3)的最后一步中第二个因素的发展与LDA计算类似,不同之处在于,计算每个文档的主题计数,给出

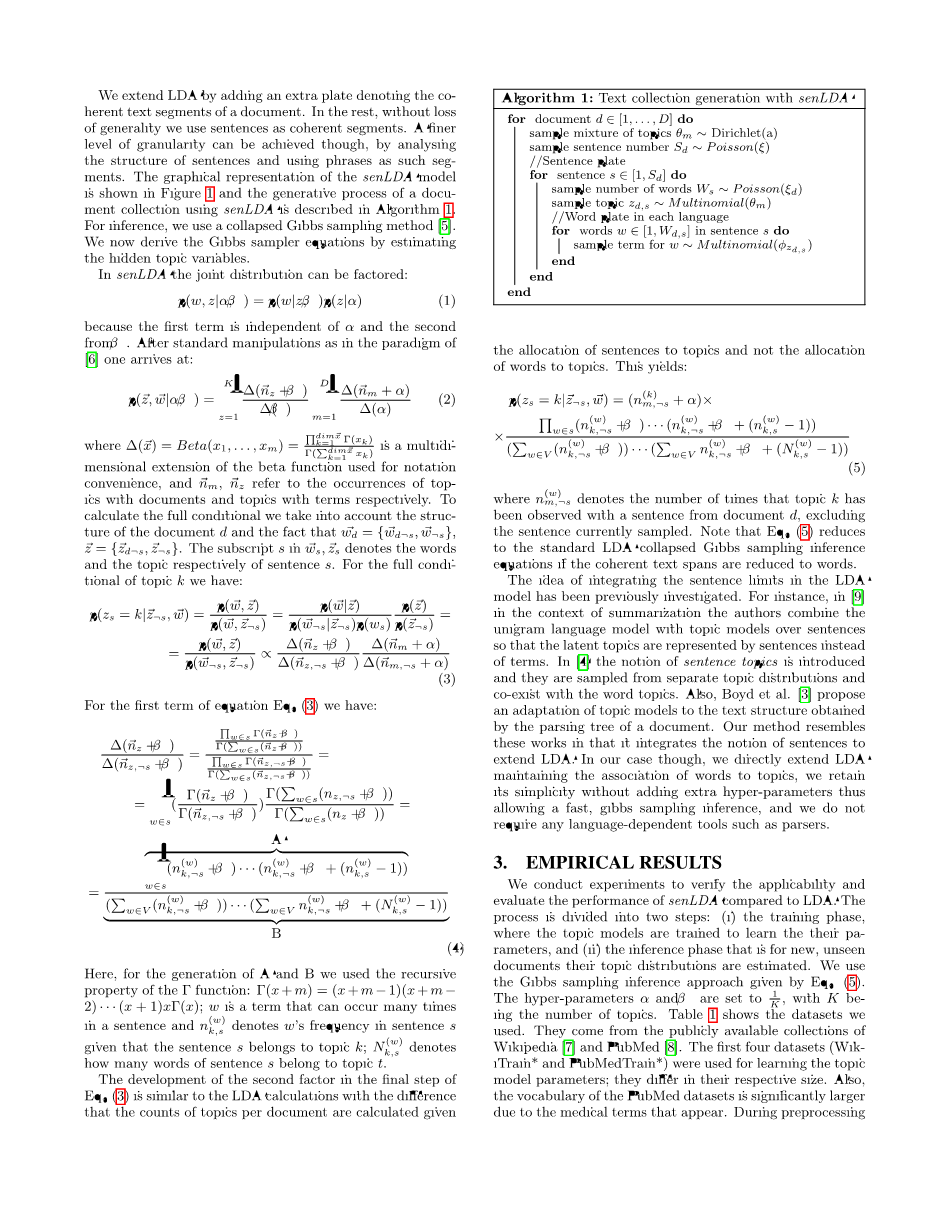

算法一:用senLDA生成文本集合

给主题分配句子,而不是给主题分配单词。 这产生:

(5)

其中表示排除了当前采样的句子后,从文档d中的句子中观察到话题k的次数。 这产生了等式5,其中S1表示用文档d中的句子观察到话题k的次数,排除了当前采样的句子。 注意,如果相干文本跨度被简化为单词,则等式(5)简化为标准的LDA折叠吉布斯采样推断方程。

先前已经研究了将句子限制整合到LDA模型中的想法。 例如,在[9]的总结中,作者将单语言模型与句子上的主题模型相结合,以便潜在主题由句子而不是术语表示。 在文献[4]中引入了句子主题的概念,并且它们从单独的主题分布中抽样并与主题单词共存。 另外,Boyd等人 [3]提出了一个文本解析树获得的文本结构主题模型的适应。 我们的方法类似于这些作品,它集成了句子的概念来扩展LDA。 在我们的例子中,我们直接扩展了LDA,保持了单词与主题的关联,我们保留了它的简单性,而没有增加额外的超参数,因此允许快速的吉布斯抽样推断,并且我们不需要任何与语言相关的工具,如解析器。

3.实验结果

我们进行实验来验证senLDA与LDA相比的适用性和评估性能。该过程分为两个步骤:(i)训练阶段,其中主题模型被训练以了解其参数;以及(ii)推断阶段针对新的,未被看见的文档估计其主题分布。我们使用由方程式(5)给出的吉布斯采样推理方法。超参数alpha;和beta;被设置为1 / K,其中K是话题的数量。表1显示了我们使用的数据集。他们来自公开可用的维基百科[7]和PubMed [8]。前四个数据集(Wik- iTrain *和PubMedTrain *)用于学习主题模型参数;它们的大小各不相同。此外,由于出现医学术语,PubMed数据集的词汇量显着增大。在预处理过程中,我们只使用WordNet Lemmatizer应用低层包装,停用词清除和词形化。表1的其余文档集合用于分类目的,将在本节稍后讨论。

表1:预处理后使用的数据的描述。 “定时”是指第一次训练迭代,其中左(右)值对应于senLDA(或LDA)。

图2: 根据Wiki37和PubMed25计算的senLDA和LDA的困惑率。

内在评估主题模型评估一直是激烈研究的主题。 对于内在评估,我们在这里报告复杂性[1],这可能是参考书目中主题模型评估的主要措施。 给定模型参数的文档d的复杂性定义为这些数据的标记可能性的倒数几何均值,给定模型的参数:

(6)

请注意,senLDA对每个句子采样,因此导致在计算困惑度的单词级别上灵活性较差。 尽管senLDA和LDA在单词级别上使用困惑之间的比较提供了对所提议的模型的相对优点的见解。

图2描绘了senLDA和LDA之间的困惑度值的比率。在进行5倍交叉验证训练数据,网格搜索K={25; 75; 125; 175} 之后,我们设置K = 125。高于(低于)的值表示senLDA达到比LDA更低(或更高)的困惑度。该图表明,在两个模型收敛之前的第一次迭代中,senLDA表现更好。更重要的是,senLDA仅在约30次迭代后收敛,而LDA在维基百科160次迭代后收敛,PubMed数据集上迭代次数为200次。我们将收敛定义为模型的困惑在训练迭代中不再减少的情况。图中的阴影部分突出显示了周期,而senLDA表现更好。值得注意的是,虽然具有竞争力,但由于无限的时间资源,senLDA并没有超过LDA。然而,由于senLDA的训练实例是句子,所以期待这样的结果,因此模型的灵活性在针对基于单词的测量进行评估时受到限制。

然而,这些模型之间的一个重要区别在于它们汇合的方式。从图2可以看出,senLDA收敛速度更快。我们通过在使用Intel Xeon CPU E5-2643 v3(3.40GHz)的机器上为模型的前25次迭代(表1的列“Timing”)提供确切的时序,对于这两种模型,我们都使用自己的Python实现相同的速度优化使用'WikiTrain2'和125个主题,对于25次迭代,senLDA需要332秒,而LDA需要434秒,提高30%。此外,比较收敛性,senLDA需要332秒(25次迭代),而LDA需要超过2770秒(超过160次迭代),使senLDA速度提高8倍以上。同样,由于词汇量较大,“PubMedTrain2”数据集更复杂,senLDA收敛速度快12倍(一个数量级)。请注意,senLDA的快速收敛性是一个强大的优势,可以在不限时间资源不可用的不同应用场景中得到高度赞赏。

外在评估以前的研究表明,困惑并不总是与人类对主题模型的评估一致[1],并且建议评估关于真实任务的主题模型。为了更好地支持我们的senLDA适用性开发,我们还使用文本分类作为评估任务对其进行评估。对于文本分类,每个文档由其主题分布表示,这是支持向量机(SVM)的向量输入。分类集合分为训练/测试(75%/ 25%)部分。支持向量机正则化超参数lambda;从lambda;isin;[10-4,hellip;hellip;,104]中选择,在分类数据的训练部分使用5次交叉验证。 PubMed测试集是多标记的,即每个实例都与几个类相关联,表1中的平均值为1.4。对于支持向量机的多标记问题,我们使用二元相关性方法。为了评估分类性能,我们报告了F1评估量度,即精确度和召回率的调和平均值。

图3:使用F1度量对PubMed和Wikipedia文本集合进行分类。

不同分类数据集的F1度量的分类性能如图3所示。首先我们注意到,在大多数分类场景中,senLDA优于LDA。在大多数情况下,当使用较大的训练集(“WikiTrain2”和“PubMedTrain2”)时,性能差异会增加。例如,在PubMed分类实验的第二行中,增加主题模型的训练数据对LDA和senLDA都有好处,但senLDA仍然表现更好。更重要的是,尽管并且与困惑性实验一致,senLDA的优势依然存在:更快的senLDA收敛性有利于分类性能。 senLDA曲线在第一次训练迭代中更陡峭,并且在模型收敛大约30次迭代后稳定下来。我们认为将潜在话题分配给相应的单词组,例如句子会得到更精细的文档表示。在这个意义上,跨度大于单个单词可以更有效地捕获和表达文档的内容,用于分类等区分性任务。

为了调查在不同文本层次上学习的主题模型表示的相关性,我们使用文档表示法来报告LDA和senLDA输出的文档主题分布的连接。例如,当每个模型的K = 125时,文档的连接矢量表示是250维的向量。得到的连接表示在图3中用“senLDA ”表示。可以看出,与LDA和senLDA相比,“senLDA ”表现更好,其性能结合了两种模型的优点:在第一次迭代期间,它与senLDA表示一样陡峭,并且在后面的迭代中LDA收敛优于优于因此,这两个分布的连接创建了一个更丰富的表示,其中两个模型贡献了互补信息,从而实现了最佳分类性能。使用这些表示实现最佳性能表明,放宽文本结构单位可能是有益的;这也是这项工作的贡献。 4.总结

我们提出了senLDA,这是LDA的扩展,其中主题是按照相关文本跨度进行抽样的。 这导致了非常快的收敛和良好的分类和困惑表现。 LDA和senLDA的不同之处在于,第二种假设对句子之间的潜在主题具有非常强的依赖性,而第一种假设一般假定文档之间的语言是独立的。 在我们未来的研究中,我们的目标是调查这种依赖关系,并进一步调整主题模型的采样过程以应对丰富的文本结构。

致谢

这项工作得到了CIFRE N 28/2015的部分支持。

参考文献

[1] L. Azzopardi, M. Girolami, and K. van R

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[22656],资料为PDF文档或Word文档,PDF文档可免费转换为Word

课题毕业论文、外文翻译、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。