英语原文共 13 页,剩余内容已隐藏,支付完成后下载完整资料

基于时空深特征的视频显著目标检测

Trung-Nghia Le and Akihiro Sugimoto

本文提出了一种检测视频中显著对象的方法,其中除了空间信息之外,充分考虑了时间信息。继最近的报告对传统手工制作的特点的深度特征的优势,我们提出了时空深度(STD)的特点,利用本地和全局上下文的框架。我们还提出了时空条件随机场(STCRF)来计算STD特征的显著性。STCRF是CRF向时域扩展,并在帧和帧之间形成相邻区域之间的关系。STCRF导致帧上的时间一致显著性图,有助于准确检测突出对象的边界和减少检测中的噪声。我们提出的方法首先将输入视频分割成多个尺度,然后利用STCRF的STD特征在每个尺度水平上计算显著图。最后的显著性图是通过在不同的尺度水平融合显著性图来计算的。我们使用公开可用的基准数据集的密集实验证实,所提出的方法显著优于现有技术的方法。我们还将我们的显著性计算应用到视频对象分割任务,表明我们的方法优于现有的视频对象分割方法。

索引视频显著性,突出对象检测,SPA -颞深特征,时空CRF,视频对象分割。

- 介绍

视频中的显著目标检测在许多计算机视觉应用中起着重要的作用,如视频重定位[1]、目标检测[2]、人再识别[3]和视觉跟踪[4]。用于显著目标检测的常规方法通常将每个帧分割成区域,并人工地结合低水平(自底向上)特征(例如强度[5]、颜色[5]、边缘取向[6])与启发式(自上而下)先验(例如,中心先验[7]、边界先验[5]、目标性[6])检测。这些地区。低级别的特点和先验使用的手工制作,并不够强大的挑战性的情况下,尤其是当突出的OB喷射呈现在低对比度和杂乱的背景。虽然最近已经开发了基于机器学习的方法[8][9][10],但它们主要是用于整合不同手工制作的特征[9] [11]或融合各种方法产生的多个显著图[8]。因此,当突出对象接触图像边界或与背景具有相似的外观时,它们通常无法保存对象细节,因为手工制作的特征在那里不稳定。

Trung Nghia Le与信息学系,索肯达(高级研究生研究生院),东京,日本。

Akihiro Sugimoto在日本东京国家信息研究所工作。

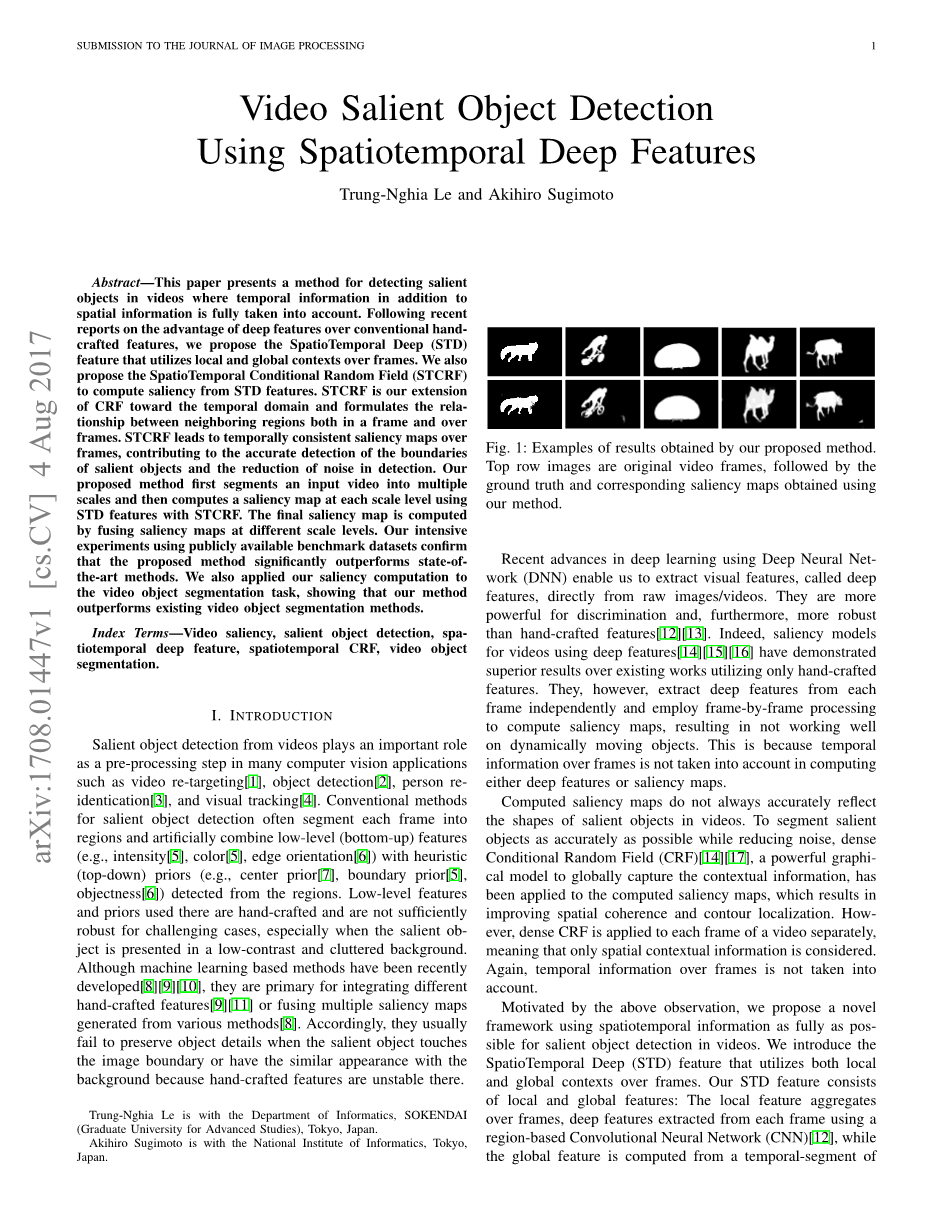

图1:我们提出的方法得到的结果的例子。顶行图像是原始视频帧,其次是地面真理和相应的显著性地图使用我们的方法获得。

使用深度神经网络(DNN)进行深度学习的最新进展使我们能够直接从原始图像/视频中提取视觉特征,称为深特征。它们对辨别力更强大,而且比手工制作的特征更稳健[12][13]。事实上,使用深特征的视频的显著性模型[14][15][16]在仅利用手工制作的特征的现有作品上表现出优异的结果。然而,它们独立地从每个帧中提取深度特征,并采用逐帧处理来计算显著性图,从而导致对动态移动对象的不工作。这是因为在计算深度特征或显著性图时,不考虑帧上的时间信息。

计算显著性图并不总是准确地反映视频中突出对象的形状。为了在降低噪声的同时尽可能精确地分割突出对象,将稠密条件随机场(CRF)[14][17]作为一种全局捕获上下文信息的强大的图形模型,应用于计算显著性图,从而提高空间相干性和连续性。我们的本土化。如何将密集CRF分别应用于视频的每个帧,这意味着只考虑空间上下文信息。同样,不考虑帧上的时间信息。

出于上述观察,我们提出了一种新的框架,充分利用时空信息作为POS可用于视频中的显著目标检测。我们介绍了时空深度(STD)的特点,利用本地和全局上下文的框架。我们的STD特征包括局部和全局特征:局部特征聚集在帧上,使用基于区域的卷积神经网络(美国有线电视新闻网)[12]从每个帧中提取深特征,而全局特征由基于块的CNn的视频的时间段计算[13]。我们还介绍了基于STD特征的时空CRF(STCRF),其中帧间区域之间的空间关系以及帧上区域的时间一致性被制定。我们提出的方法首先将输入视频分割成多尺度水平,然后在每个尺度水平上

提取STD特征并计算显著图。然后,该方法将不同尺度的显著性图融合到最终显著性图中。我们在公共基准数据集的视频显著性的广泛实验证实,我们所提出的方法显著优于-ART的状态。我们的方法获得的显著性图的例子如图1所示。我们还将我们的方法应用到视频对象分割,并发现我们的方法优于现有的方法。

本文的其余部分整理如下。第二节简要回顾和分析相关工作。然后,我们在第三节中详细介绍了我们提出的方法。在第四和第五节中显示了密集的实验。在第六节中,我们提出了我们所提出的方法用于视频对象分割。第七部分是结论和今后的工作。我们注意到这项工作的一部分已经在[18]中报道过。

- 相关工作

在这里,我们简要地调查了用于视频中的显著目标检测的特征,以及显著性计算方法。

- 用于显著目标检测的特征

使用手工制作的特征的视频显著性计算方法大多是通过将运动特征与运动对象结合起来的传统图像显著性模型[6][7][10][19]而发展出来的。常用的运动特征有光流[6][7][19]和局部特征轨迹[10][20]。其他运动特征,如梯度流场[21]和时间运动边界[22]也被使用:它们被用来检测视频中的显著对象。薛等,[23],另一方面,将视频沿着X -T和Y -T平面分割,以将前景移动物体与背景分开。然而,手工制作的特征在捕捉对象的语义概念方面具有局限性。因此,当突出物体接触图像边界或与背景具有相似的外观时,这些方法通常会失败。

另一方面,使用深度特征的显著性计算的几种现有方法[14][24]利用超像素分割以不同的方式提取区域级深部特征(例如,将进给区域单独地输入到美国有线电视新闻网中以计算深特征[24]或汇集像素级特征M。AP进入区域以获得区域级深部特征[14]。为了利用多尺度的区域背景,通过改变窗口大小[24]提取区域的多尺度深度特征。Li等人[24]融合了感兴趣区域的多尺度深特征,用两层DNN计算区域的显著性得分。手工制作的特征也被集成到深部特征中,以提高显著目标检测的精度[16]。Wang等人[16]将编码的低层距离图和来自美国有线电视新闻网的高级特征串接起来,以丰富所提取的特征中包含的信息。区域级特征映射和像素级特征映射也被集成到显著性模型中,以提高检测到的对象边界的准确度[14]。在端到端深显著性模型[15][25]中,通过递归CNNs通过上下文信息增强基于像素的深层特征。

使用深特征的显著性模型已经证明了在显著目标检测中的最新性能,并且仅利用手工制作的特征显著地优于现有的作品。然而,在深度特征上没有考虑到帧上的时间信息,导致这些方法在动态移动对象上不能很好地工作。因此,有效地利用空间域和时域域来实现显著性计算的强大深度特征仍然是一个挑战。

- 显著性计算方法

使用深模型[14][15][17][25][26]的显著目标检测方法直接从完全卷积网络计算显著性得分。在这些深度模型中,利用递归层[15][25]和跳过连接[15][17]来增强深层特征图的上下文信息,以提高显著性计算的精度。然而,这些方法侧重于逐帧处理,而不考虑视频中的任何时间信息。因此,它们不能很好地动态地移动视频中的对象。此外,它们还没有准确地检测出突出物体的边界。为了提高检测对象边界的精度,通常需要细化作为后处理。

空间CRF具有关联相邻区域以捕获全局上下文的能力,并且常用于语义分割[27]和显著性计算[14][17]中的细化。密集的CRF[28]被用作后处理以改进从CNS生成的标签映射,以提高语义分割的性能[27]。Shimoda等人[27]开发了一种弱监督的语义分割方法,使用密集CRF来改进来自不同类别显著图的结果。密集CRF被纳入从美国有线电视新闻网计算的显著性地图,以改善空间相干性和轮廓定位[14][17]。虽然在这些方法中利用CRF成功地利用空间信息,但是要考虑如何处理时间信息,这对于视频是至关重要的。

动态CRF(DCRF)[29]从空间CRF扩展到时空域,利用视频中的SPA和时间信息。DCRF由连续视频帧构成,其中每个像素在空间(即同一帧)和时间(即下一帧和前一帧)连接到其相邻像素。DCRF已经被用于增强对象分割的空间精度和时间相干性[29][30][31]和显著性计算[10]在视频中。[31]提出了一种利用DCRF改进视频中栅栏分割的框架。Wang等人[29][30]将DCRF应用于室内视频场景中的目标分割和运动阴影分割。

Multiscale

Video Segmentation

Multiscale

Saliency Aggregation

Final Saliency Map

Spatiotemporal

Deep Feature Saliency

Extraction Computation

Saliency Map

STD Feature Map

Temporal Segment

单尺度管道

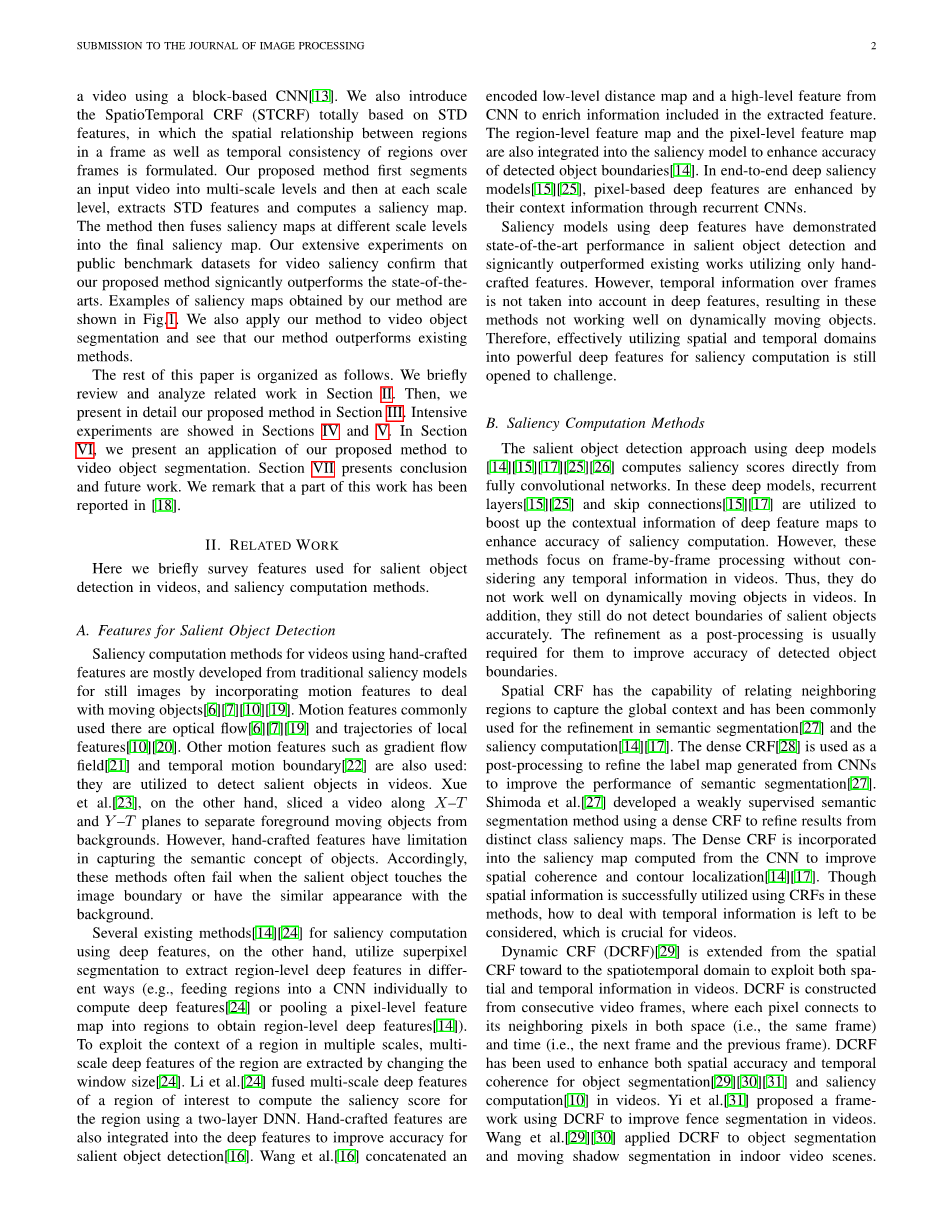

图2:所提出的方法的流水线。

SIFT流特征被结合到DCRF中以从视频中检测突出对象[10]。然而,DCRF是像素级稠密图;因此,由于内存消耗大,通常只使用两个连续帧来构造。此外,由于DCRF的能量函数完全基于经典手工制作的特征,如颜色和光流的组合,DCRF缺乏利用语义上的空间和时间信息。我们提出的STCRF不同于DCRF,因为STCRF仅使用STD特征在区域上定义,使得它能够处理更连续的帧,并且利用更少的计算成本更具语义地利用空间和时间信息。

与现有的方法不同,我们所提出的方法在提取深度特征和计算显著性地图时尽可能地利用空间信息。我们提出的显式计算使用STD特征与STCRF产生准确的显著性地图在空间和时间域。特别地,突出对象的边界被精确地检测,并且减少噪声。

-

提出的方法

- 概述

我们的目标是计算显著性地图,以准确地从输入视频中分割出每个帧中的突出对象,并记住尽可能充分利用时间信息。图2说明了我们提出的方法的流水线。

我们在多个尺度上分割输入视频,并在每个帧上计算每个尺度上的显著图,然后将每个帧中的不同尺度上的所有显著性图聚集到最终显著图中。这遵循我们的直觉,视频中的对象包含各种显著的尺度模式,并且在较粗的尺度上的对象可以以更精细的尺度由多个部分组成。在这项工作中,我们采用视频分割方法(32)在四个级别的水平。在分割过程中,我们得到多尺度时间超像素。在每个尺度上,对应的超像素通过帧连接。我们还指出,每个分割级别具有不同数量的超像素,它们被定义为非重叠区域。

-

- 时空深特征提取

我们提出的STD特征是局部和全局特征的级联。使用基于区域的美国有线电视新闻网来提取局部特征,然后在帧上聚集,而全局特征用基于块的美国有线电视新闻网计算,其输入是视频的时间段。STD特征提取在图3中示出。

-

-

- 局部特征提取:将每个帧的分割区域(即超像素)馈送到基于区域的美国有线电视新闻网,以提取其基于区域的特征。作为我们基于区域的美国有线电视新闻网,我们使用在IEMASNET ILVRC-2013挑战数据集[33]上预先训练的公开可用的R-CNN模型[12]。我们注意到,在提取基于区域的特征时,我们没有执行微调。

-

基于区域的特征包含区域的局部上下文,但不包含时间信息,因为它是明智地计算帧。为了合并时态信息,我们在帧上聚集基于区域的特征,从而导致帧上一致的局部特征。仅仅基于帧平均的基于区域的特征是不明智的,因为随着时间的推移,由于有损压缩而出现像素波动,从而降低了对应于帧的区域的精度。相对于帧的时间距离,这种退化变得更大。因此,我们在相邻帧中线性地组合基于区域的特征,类似于[6],使用以帧中心为中心的高斯分布建模的权重来计算其局部特征。利用这些权重,在具有较大距离到感兴趣帧的帧上的基于区域的特征,对帧的局部特征贡

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[22859],资料为PDF文档或Word文档,PDF文档可免费转换为Word

课题毕业论文、外文翻译、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。