英语原文共 6 页,剩余内容已隐藏,支付完成后下载完整资料

2.基于字符串的相似度

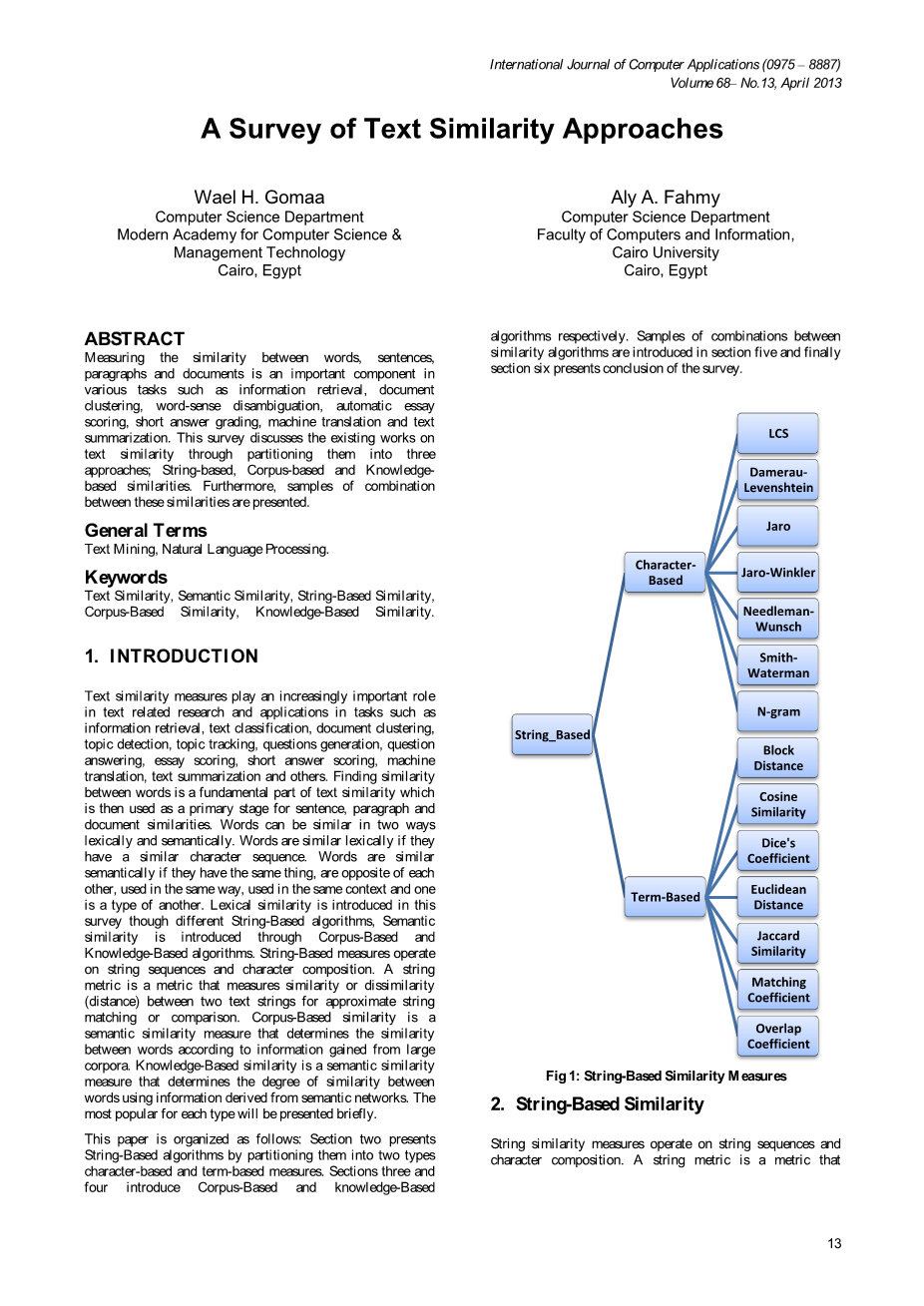

字符串相似度度量操作字符串序列和字符组成。字符串度量是度量两个文本字符串之间的相似性或不同(距离)的度量,用于近似字符串匹配或比较。这个调查代表了在SimMetrics包中实现的最流行的字符串相似性度量[1]。如图1所示,将简要介绍14种算法;其中7个是基于字符的,另一个是基于词汇的距离度量。

2.1 基于字符的相似度方法

最长公共子串(LCS)算法考虑到两个字符串之间的相似度是基于两个字符串中存在的连续字符链的长度。

Damerau-Levenshtein通过计算将一个字符串转换为另一个字符串所需的最小操作数来定义两个字符串之间的距离,其中一个操作被定义为一个字符的插入、删除或替换,或者是两个相邻字符的转位[2,3]。Jaro基于两个字符串之间的普通字符的数量和顺序;它考虑了典型的拼写偏差,主要用于记录链接领域。(4、5)。

Jaro - winkler是Jaro距离的延伸;它使用了一个前缀scale,它为字符串提供了更有利的评级,从一个前缀[6]开始。Needleman-Wunsch算法是动态规划的一个例子,是动态规划对生物序列比较的第一个应用。它执行全局对齐,以在整个两个序列中找到最佳的对齐方式。当这两个序列长度相似时,它是合适的,在整个[7]中具有显著的相似性。

Smith-Waterman是动态编程的另一个例子。它执行局部对齐,以找到两个序列的保守域的最佳对齐方式。对于被怀疑包含相似或相似序列母题的不同序列,在其较大的序列背景下,它是有用的[8]。

n -gram是一个给定序列的n项的子序列。N-gram相似算法将n-g从每个字符或两个字串中进行比较。距离的计算方法是将相似n-g的数量除以n-g的最大值[9]。

2.2 基于词汇的相似度方法

街区距离也被称为曼哈顿距离,boxcar距离,绝对值距离,L1距离,城市街区距离和曼哈顿距离。它计算出从一个数据点到另一个数据点之间的距离,如果遵循类似网格的路径。两个项之间的块距离是其对应分量的差值之和[10]。余弦相似度是度量一个内积空间的两个向量之间的相似度的度量,它测量了它们之间夹角的余弦值。在两个字符串[11]中,骰子的系数被定义为比较字符串中常用项数的两倍。欧几里得距离或L2距离是两个向量对应元素的平方和的平方根。

Jaccard相似度被计算为在两个字符串中所有唯一项的数目上的共享项数[12]。匹配系数是一种非常简单的基于向量的方法,它只计算相似项的数目(维数),这两个向量都是非零的。重叠系数类似于骰子的系数,但如果一个是另一个的子集,则认为两个字符串是完全匹配的。

3.基于语料库的相似度

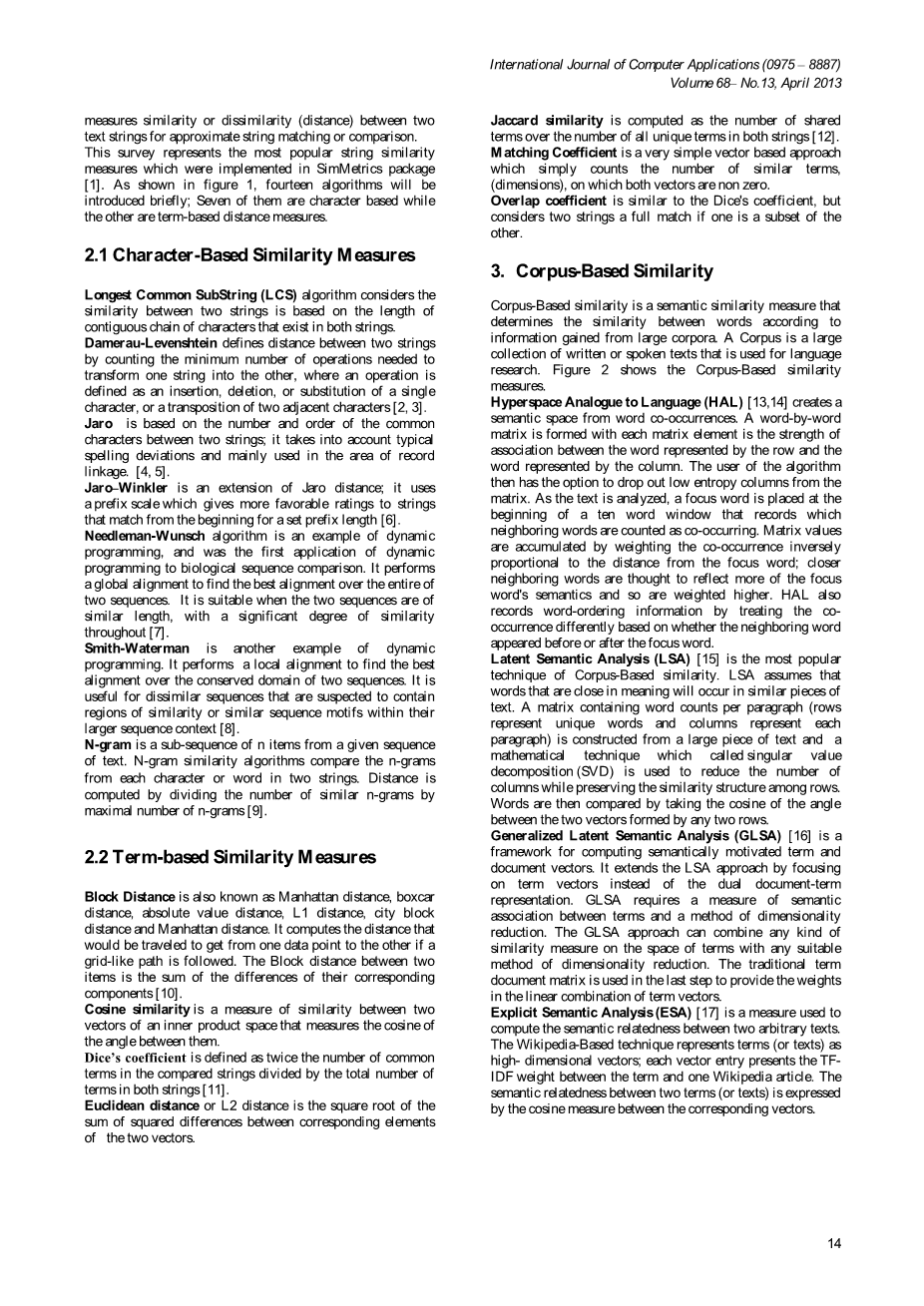

基于语料库的相似度是一种语义相似度测度,它根据从大型语料库获得的信息来判断单词之间的相似性。语料库是一大批用于语言研究的书面或口头文本。图2显示了基于corba的相似性度量。超空间模拟语言(HAL)[13,14]创造了一个从词共发生的语义空间。每个矩阵元素都是一个逐字的矩阵,它是由行表示的单词和由列表示的单词之间的联系强度。该算法的用户可以选择从矩阵中退出低熵列。当文本被分析时,一个焦点词被放置在十个单词窗口的开头,这个窗口记录相邻的单词被计算为共同发生。矩阵值是通过加权与焦点词的距离成反比来累积的;更紧密的邻接字被认为反映了更多的焦点词的语义,所以权重更高。HAL还记录了单词排序的信息,方法是根据相邻的单词出现在焦点单词之前还是之后,以不同的方式处理这个事件。潜在语义分析(LSA)[15]是基于语料库相似性的最流行的技术。LSA假设相近的单词会出现在类似的文本中。一个包含每个段落的单词计数的矩阵(行表示每个段落的唯一的单词和列)是由一个大的文本组成的,一个叫做奇异值分解(SVD)的数学技巧用于减少列的数量,同时保留行之间的相似结构。然后,通过对任意两行形成的两个向量夹角的余弦进行比较。广义潜在语义分析(GLSA)[16]是一种计算语义动机的术语和文档向量的框架。它通过关注术语向量而不是双文档术语表示来扩展LSA方法。GLSA要求术语之间语义关联的度量和维度减少的方法。GLSA方法可以将任何种类的相似性度量与任何合适的维度缩减方法相结合。在最后一步中使用传统的术语文档矩阵,在术语向量的线性组合中提供权重。显式语义分析(ESA)[17]是用来计算两个任意文本之间的语义相关性的一种度量方法。基于wiki的技术将术语(或文本)表示为高维向量;每个向量条目在术语和一篇Wikipedia文章之间呈现TFIDF权重。两项(或文本)之间的语义相关性是由对应向量之间的余弦度量表示的。

图2 基于语料库的文本相似度

跨语言显式语义分析(CLESA)[18]是ESA的多语言概括。CL-ESA利用了一个文档对齐的多语言参考集合,如Wikipedia,将文档表示为语言独立的概念向量。两种不同语言的文档之间的相关性是由对应的向量表示之间的余弦相似度来评估的。点态互信息-信息检索(PMI-IR)[19]是一种计算单词间相似度的方法,它使用AltaVista的高级搜索查询语法来计算概率。在web页面上,两个词的相互作用越频繁,它们的PMI-IR相似性得分就越高。二阶共发生点互信息(SCO-PMI)[20,21]是一种利用点互信息对两个目标词的重要相邻词进行排序的语义相似性度量。使用SOC-PMI的优点是,它可以计算两个不经常发生的单词之间的相似度,因为它们与相邻的单词一起出现。归一化谷歌距离(NGD)[22]是由谷歌搜索引擎为给定的一组关键字返回的命中次数而产生的语义相似性度量。在自然语感中具有相同或相似意义的关键词在谷歌距离的单位中趋向于“接近”,而具有不同含义的单词往往相距较远。具体地说,两个搜索项x和y之间的归一化谷歌距离是:

其中M为谷歌搜索的web页面总数;f(x)和f(y)分别是搜索项x和y的命中次数;f(x, y)是x和y发生的网页数。如果两个搜索项x和y在同一个web页面上不出现在一起,但是单独发生,那么它们之间的标准化谷歌距离是无限的。如果两个条件总是同时发生,它们的NGD等于0,或者等于xsup2;和ysup2;的系数。

通过使用co(DISCO)[23, 24]的分布相似度来提取分布相似的词,假设在相似的上下文中有相似意思的单词。大量的文本集合被统计分析以得到分布的相似性。DISCO是一种通过使用一个简单的大小的上下文窗口来计算单词之间的分配相似性的方法。当两个词受到精确的相似性时,DISCO仅仅是从索引数据中检索词向量,并根据Lin的度量计算相似度[25]。如果需要的是分布最广的单词;DISCO返回给定单词的第二个顺序词向量。迪斯科有两种主要的相似度:迪斯科和迪斯科;根据它们的配置集计算两个输入词之间的一阶相似度。在两种输入词之间,根据它们的分布相似的词来计算二阶相似度。

4. 基于知识的相似度

基于知识的相似度是语义相似度度量的一种,它是基于语义网络的信息来识别词语之间的相似性程度[26]。WordNet[27]是最流行的语义网络,它是衡量词汇之间基于知识的相似性的领域;WordNet是一个大型的英语词汇数据库。名词、动词、形容词和副词被分为认知同义词组(synsets),每个词都表达一个不同的概念。摘要通过概念语义和词汇关系,相互联系。

如图3所示,基于知识的相似性度量可以大致分为两组:语义相似性度量和语义相关性度量。语义上相似的概念被认为是与它们的相似度相关的。另一方面,语义关系是一种更为普遍的关联性概念,而不是与概念的形状或形式有关。换句话说,语义相似是两个词之间的一种亲缘关系,它涵盖了概念之间更广泛的关系,其中包括额外的相似性关系,比如is-a-kind-of, is-a- -of[28]。有六种语义相似性度量方法;其中三种是基于信息内容:Resnik (res)[29]、Lin (Lin)[25]和Jiang amp; Conrath[30]。[31],Wu amp; Palmer (wup)[32]和路径长度(path)。

res度量中的相关值等于最不常用的子sumer(最富信息的子sumer)的信息内容(IC)。这意味着该值将永远大于或等于零。值的上界通常相当大,取决于用于确定信息内容值的主体的大小。lin和jcn的测量方法是将最不常见的子sumer的信息内容与概念A和B本身的信息内容的和相加。lin测量通过这个和来衡量最小公共子sumer的信息内容,而jcn则将这个总和和最小公共子sumer的信息内容区别开来。

图3 基于知识的相似度

lch测量返回一个分数,表示两个单词感觉的相似度,基于连接感官的最短路径和感觉发生的分类法的最大深度。wup测量的结果是,根据分类法中两种感觉的深度和它们最不常见的子sumer的深度,得出两个单词感觉的相似程度。路径测量返回一个分数,它表示两个单词的感觉是多么相似,这是基于在isa (hypernym/催眠)分类法中连接感官的最短路径。

此外,语义关联性有三种度量方法:St.Onge (hso)[33]、Lesk (Lesk)[34]和向量对(vector)[35]。hso的测量方法是通过寻找连接两个单词感觉的词汇链。有三种类型的关系被认为:超强、强、中强。最大亲缘得分为16。lesk的测量方法是在两个同步器的注释中找到重叠部分。亲缘分数是重叠长度的平方和。向量度量创建了一个在给定语料库中使用的每个词的共现矩阵,然后用一个向量表示每一个光/概念,这个向量是这些共现向量的平均值。基于知识的相似性度量的最流行的包是WordNet::相似的1和自然语言工具箱(NLTK)2。

5.混合的相似度算法

混合方法采用多种相似性度量;许多研究覆盖了这一领域。在[26]中测试了8种语义相似性度量。其中两项措施是基于核心的措施,另外六项是基于知识的。首先,分别对这八种算法进行了评价,然后将它们组合在一起。最好的性能是通过将几个相似度指标组合成一个的方法实现的。

在[36]中提出了一种基于语义和词序信息来衡量句子或非常短的文本之间语义相似度的方法。首先,语义相似是从词汇知识库和语料库中派生出来的。第二,提出的方法考虑词序对句子意义的影响。派生词序相似性度量不同单词的数量,以及不同顺序的单词对的数量。

[37]的作者提出了一种方法,并将其命名为语义文本相似性(STS)。该方法通过语义和句法信息的结合来确定两个文本的相似度。他们考虑了两个强制性的函数(字符串相似度和语义词相似度)和一个可选函数(共词序相似度)。STS方法对30个句子对数据集的Pearson相关系数非常好,且优于[36]。

[38]的作者提出了一种方法,将基于语料库的语义关联性和基于知识的语义相似性得分结合在一起。所有的分数都被输入到机器学习模型中,如线性回归,和装填模型,以获得一个分数,给出句子之间的相似度。该方法对基于知识的相似性测度和基于语料库的基于语料库的度量方法的语义相似度的计算有了显著的改进。

在[39]中,通过合并两个模块,实现了手动和自动相似结果之间的一种有希望的相关性。第一个模块使用基于N-gram的相似性计算句子之间的相似度,第二个模块使用概念相似性度量和WordNet计算两个句子中概念之间的相似性。在[40]中引入了一个具有合理相关结果的UKP系统,利用基于训练数据的简单对数线性回归模型,结合多个文本相似度度量。这些措施包括字符串相似性、语义相似性、文本扩展机制以及与结构和风格相关的度量。UKP的最终模型由大约20个特征的对数线性组合构成,超出了可能实现的300个特性。

剩余内容已隐藏,支付完成后下载完整资料

资料编号:[23378],资料为PDF文档或Word文档,PDF文档可免费转换为Word

课题毕业论文、外文翻译、任务书、文献综述、开题报告、程序设计、图纸设计等资料可联系客服协助查找。